mirror of

https://github.com/THU-MIG/yolov10.git

synced 2026-01-20 16:55:28 +08:00

Update https://docs.ultralytics.com/models (#6513)

Signed-off-by: Glenn Jocher <glenn.jocher@ultralytics.com> Co-authored-by: pre-commit-ci[bot] <66853113+pre-commit-ci[bot]@users.noreply.github.com>

This commit is contained in:

parent

0c4e97443b

commit

16a13a1ce0

191

docs/ar/models/fast-sam.md

Normal file

191

docs/ar/models/fast-sam.md

Normal file

@ -0,0 +1,191 @@

|

|||||||

|

---

|

||||||

|

comments: true

|

||||||

|

description: استكشف FastSAM ، وهو حلاً مبنيًا على الشبكات العصبية السريعة لتجزئة الكائنات في الوقت الحقيقي في الصور. تفاعل المستخدم المحسّن ، والكفاءة الحسابية ، والقابلية للتكيف في مهام الرؤية المختلفة.

|

||||||

|

keywords: FastSAM ، التعلم الآلي ، حلاً مبنيًا على الشبكات العصبية السريعة ، قسيمة الكائنات ، حلاً في الوقت الحقيقي ، Ultralytics ، مهام الرؤية ، معالجة الصور ، تطبيقات صناعية ، تفاعل المستخدم

|

||||||

|

---

|

||||||

|

|

||||||

|

# نموذج تجزئة أي شيء بسرعة عالية (FastSAM)

|

||||||

|

|

||||||

|

نموذج تجزئة أي شيء بسرعة عالية (FastSAM) هو حلاً مبتكرًا للعصب الشبكي يعمل بالزمن الحقيقي لمهمة تجزئة أي كائن داخل صورة ما. تم تصميم هذه المهمة لتجزئة أي كائن داخل صورة بناءً على إشارات تفاعل المستخدم المختلفة الممكنة. يقلل الـ FastSAM من الاحتياجات الحسابية بشكل كبير مع الحفاظ على أداء تنافسي ، مما يجعله خيارًا عمليًا لمجموعة متنوعة من مهام الرؤية.

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

## نظرة عامة

|

||||||

|

|

||||||

|

تم تصميم FastSAM للتغلب على القيود الموجودة في [نموذج تجزئة ما شيء (SAM)](sam.md) ، وهو نموذج تحويل ثقيل يتطلب موارد حسابية كبيرة. يفصل FastSAM عملية تجزئة أي شيء إلى مرحلتين متسلسلتين: تجزئة جميع الأمثلة واختيار موجه بناءً على التعليمات. تستخدم المرحلة الأولى [YOLOv8-seg](../tasks/segment.md) لإنتاج قناع التجزئة لجميع الأمثلة في الصورة. في المرحلة الثانية ، يتم إخراج منطقة الاهتمام المتعلقة بالتعليمة.

|

||||||

|

|

||||||

|

## المميزات الرئيسية

|

||||||

|

|

||||||

|

1. **حلاً في الوقت الحقيقي**: من خلال استغلال كفاءة الشبكات العصبية الحاسوبية ، يوفر FastSAM حلاً في الوقت الحقيقي لمهمة تجزئة أي شيء ، مما يجعله قيمًا للتطبيقات الصناعية التي تتطلب نتائج سريعة.

|

||||||

|

|

||||||

|

2. **كفاءة وأداء**: يقدم FastSAM تقليل كبير في الاحتياجات الحسابية واستخدام الموارد دون التنازل عن جودة الأداء. يحقق أداءً قابلاً للمقارنة مع SAM ولكن بموارد حسابية مخفضة بشكل كبير ، مما يمكن من تطبيقه في الوقت الحقيقي.

|

||||||

|

|

||||||

|

3. **تجزئة يستند إلى الموجه**: يمكن لـ FastSAM تجزئة أي كائن داخل صورة ترشده مختلف إشارات تفاعل المستخدم الممكنة ، مما يوفر مرونة وقابلية للتكيف في سيناريوهات مختلفة.

|

||||||

|

|

||||||

|

4. **يستند إلى YOLOv8-seg**: يستند FastSAM إلى [YOLOv8-seg](../tasks/segment.md) ، وهو كاشف كائنات مجهز بفرع تجزئة المثيلات. يمكنه بشكل فعال إنتاج قناع التجزئة لجميع الأمثلة في صورة.

|

||||||

|

|

||||||

|

5. **نتائج تنافسية في الاختبارات التحضيرية**: في مهمة اقتراح الكائن على MS COCO ، يحقق FastSAM درجات عالية بسرعة أسرع بكثير من [SAM](sam.md) على بطاقة NVIDIA RTX 3090 واحدة ، مما يدل على كفاءته وقدرته.

|

||||||

|

|

||||||

|

6. **تطبيقات عملية**: توفر الطريقة المقترحة حلاً جديدًا وعمليًا لعدد كبير من مهام الرؤية بسرعة عالية حقًا ، بمعدلات سرعة عشرات أو مئات المرات أسرع من الطرق الحالية.

|

||||||

|

|

||||||

|

7. **جدوى ضغط النموذج**: يظهر FastSAM إمكانية تقليل الجهد الحسابي بشكل كبير من خلال إدخال سابق اصطناعي للهيكل ، مما يفتح إمكانيات جديدة لهندسة هيكل النموذج الكبير لمهام الرؤية العامة.

|

||||||

|

|

||||||

|

## النماذج المتاحة ، المهام المدعومة ، وأوضاع التشغيل

|

||||||

|

|

||||||

|

يعرض هذا الجدول النماذج المتاحة مع أوزانها المحددة ، والمهام التي تدعمها ، ومدى توافقها مع أوضاع التشغيل المختلفة مثل [الاستنتاج](../modes/predict.md) ، [التحقق](../modes/val.md) ، [التدريب](../modes/train.md) ، و[التصدير](../modes/export.md) ، مشار إليها برموز الـ✅ للأوضاع المدعومة والرموز ❌ للأوضاع غير المدعومة.

|

||||||

|

|

||||||

|

| نوع النموذج | أوزان تم تدريبها مسبقًا | المهام المدعومة | الاستنتاج | التحقق | التدريب | التصدير |

|

||||||

|

|-------------|-------------------------|---------------------------------------|-----------|--------|---------|---------|

|

||||||

|

| FastSAM-s | `FastSAM-s.pt` | [تجزئة المثيلات](../tasks/segment.md) | ✅ | ❌ | ❌ | ✅ |

|

||||||

|

| FastSAM-x | `FastSAM-x.pt` | [تجزئة المثيلات](../tasks/segment.md) | ✅ | ❌ | ❌ | ✅ |

|

||||||

|

|

||||||

|

## أمثلة الاستخدام

|

||||||

|

|

||||||

|

يسهل دمج نماذج FastSAM في تطبيقات Python الخاصة بك. يوفر Ultralytics واجهة برمجة تطبيقات Python سهلة الاستخدام وأوامر CLI لتسهيل التطوير.

|

||||||

|

|

||||||

|

### استخدام التوقعات

|

||||||

|

|

||||||

|

للقيام بكشف الكائنات في صورة ، استخدم طريقة `predict` كما هو موضح أدناه:

|

||||||

|

|

||||||

|

!!! Example "مثال"

|

||||||

|

|

||||||

|

=== "بايثون"

|

||||||

|

```python

|

||||||

|

from ultralytics import FastSAM

|

||||||

|

from ultralytics.models.fastsam import FastSAMPrompt

|

||||||

|

|

||||||

|

# حدد مصدر التوقع

|

||||||

|

source = 'path/to/bus.jpg'

|

||||||

|

|

||||||

|

# قم بإنشاء نموذج FastSAM

|

||||||

|

model = FastSAM('FastSAM-s.pt') # or FastSAM-x.pt

|

||||||

|

|

||||||

|

# تنفيذ توقعات على صورة

|

||||||

|

everything_results = model(source, device='cpu', retina_masks=True, imgsz=1024, conf=0.4, iou=0.9)

|

||||||

|

|

||||||

|

# قم بتجهيز كائن معالج مع قواعد التوقع

|

||||||

|

prompt_process = FastSAMPrompt(source, everything_results, device='cpu')

|

||||||

|

|

||||||

|

# التوقع باستخدام كل شيء

|

||||||

|

ann = prompt_process.everything_prompt()

|

||||||

|

|

||||||

|

# bbox الشكل الافتراضي [0،0،0،0] -> [x1،y1،x2،y2]

|

||||||

|

ann = prompt_process.box_prompt(bbox=[200، 200، 300، 300])

|

||||||

|

|

||||||

|

# التوقع النصي

|

||||||

|

ann = prompt_process.text_prompt(text='صورة لكلب')

|

||||||

|

|

||||||

|

# التوقع النقطي

|

||||||

|

ann = prompt_process.point_prompt(points=[[200، 200]]، pointlabel=[1])

|

||||||

|

prompt_process.plot(annotations=ann، output='./')

|

||||||

|

```

|

||||||

|

|

||||||

|

=== "CLI"

|

||||||

|

```bash

|

||||||

|

# قم بتحميل نموذج FastSAM وتجزئة كل شيء به

|

||||||

|

yolo segment predict model=FastSAM-s.pt source=path/to/bus.jpg imgsz=640

|

||||||

|

```

|

||||||

|

|

||||||

|

توضح هذه المقاطع البساطة في تحميل نموذج مدرب مسبقًا وتنفيذ توقع على صورة.

|

||||||

|

|

||||||

|

### استخدام مهام التحقق

|

||||||

|

|

||||||

|

يمكن تنفيذ التحقق من النموذج على مجموعة بيانات على النحو التالي:

|

||||||

|

|

||||||

|

!!! Example "مثال"

|

||||||

|

|

||||||

|

=== "بايثون"

|

||||||

|

```python

|

||||||

|

from ultralytics import FastSAM

|

||||||

|

|

||||||

|

# قم بإنشاء نموذج FastSAM

|

||||||

|

model = FastSAM('FastSAM-s.pt') # or FastSAM-x.pt

|

||||||

|

|

||||||

|

# قم بتنفيذ التحقق من النموذج

|

||||||

|

results = model.val(data='coco8-seg.yaml')

|

||||||

|

```

|

||||||

|

|

||||||

|

=== "CLI"

|

||||||

|

```bash

|

||||||

|

# قم بتحميل نموذج FastSAM وأجرِ التحقق منه بخصوص مجموعة البيانات مثال كوكو 8 بحجم صورة 640

|

||||||

|

yolo segment val model=FastSAM-s.pt data=coco8.yaml imgsz=640

|

||||||

|

```

|

||||||

|

|

||||||

|

يرجى ملاحظة أن الـ FastSAM يدعم فقط الكشف والتجزئة لفئة واحدة من الكائن. هذا يعني أنه سيتعرف ويجزء جميع الكائنات على أنها نفس الفئة. لذلك ، عند إعداد مجموعة البيانات ، يجب تحويل جميع معرفات فئة الكائن إلى 0.

|

||||||

|

|

||||||

|

## استخدام FastSAM الرسمي

|

||||||

|

|

||||||

|

يتوفر نموذج FastSAM مباشرةً من مستودع [https://github.com/CASIA-IVA-Lab/FastSAM](https://github.com/CASIA-IVA-Lab/FastSAM). فيما يلي نظرة عامة موجزة على الخطوات التقليدية التي قد تتخذها لاستخدام FastSAM:

|

||||||

|

|

||||||

|

### التثبيت

|

||||||

|

|

||||||

|

1. استنسخ مستودع FastSAM:

|

||||||

|

```shell

|

||||||

|

git clone https://github.com/CASIA-IVA-Lab/FastSAM.git

|

||||||

|

```

|

||||||

|

|

||||||

|

2. أنشئ بيئة Conda وفعّلها بـ Python 3.9:

|

||||||

|

```shell

|

||||||

|

conda create -n FastSAM python=3.9

|

||||||

|

conda activate FastSAM

|

||||||

|

```

|

||||||

|

|

||||||

|

3. انتقل إلى المستودع المنسخ وقم بتثبيت الحزم المطلوبة:

|

||||||

|

```shell

|

||||||

|

cd FastSAM

|

||||||

|

pip install -r requirements.txt

|

||||||

|

```

|

||||||

|

|

||||||

|

4. قم بتثبيت نموذج CLIP:

|

||||||

|

```shell

|

||||||

|

pip install git+https://github.com/openai/CLIP.git

|

||||||

|

```

|

||||||

|

|

||||||

|

### مثال الاستخدام

|

||||||

|

|

||||||

|

1. قم بتنزيل [تفويض نموذج](https://drive.google.com/file/d/1m1sjY4ihXBU1fZXdQ-Xdj-mDltW-2Rqv/view?usp=sharing).

|

||||||

|

|

||||||

|

2. استخدم FastSAM للتوقع. أمثلة الأوامر:

|

||||||

|

|

||||||

|

- تجزئة كل شيء في صورة:

|

||||||

|

```shell

|

||||||

|

python Inference.py --model_path ./weights/FastSAM.pt --img_path ./images/dogs.jpg

|

||||||

|

```

|

||||||

|

|

||||||

|

- تجزئة كائنات محددة باستخدام تعليمات النص:

|

||||||

|

```shell

|

||||||

|

python Inference.py --model_path ./weights/FastSAM.pt --img_path ./images/dogs.jpg --text_prompt "الكلب الأصفر"

|

||||||

|

```

|

||||||

|

|

||||||

|

- تجزئة كائنات داخل مربع محدد (تقديم إحداثيات الصندوق في تنسيق xywh):

|

||||||

|

```shell

|

||||||

|

python Inference.py --model_path ./weights/FastSAM.pt --img_path ./images/dogs.jpg --box_prompt "[570,200,230,400]"

|

||||||

|

```

|

||||||

|

|

||||||

|

- تجزئة كائنات قرب النقاط المحددة:

|

||||||

|

```shell

|

||||||

|

python Inference.py --model_path ./weights/FastSAM.pt --img_path ./images/dogs.jpg --point_prompt "[[520,360],[620,300]]" --point_label "[1,0]"

|

||||||

|

```

|

||||||

|

|

||||||

|

بالإضافة إلى ذلك ، يمكنك تجربة FastSAM من خلال [Colab demo](https://colab.research.google.com/drive/1oX14f6IneGGw612WgVlAiy91UHwFAvr9?usp=sharing) أو على [HuggingFace web demo](https://huggingface.co/spaces/An-619/FastSAM) لتجربة بصرية.

|

||||||

|

|

||||||

|

## الاقتباسات والشكر

|

||||||

|

|

||||||

|

نود أن نشكر أباء FastSAM على مساهماتهم الهامة في مجال تجزئة المثيلات في الوقت الحقيقي:

|

||||||

|

|

||||||

|

!!! Quote ""

|

||||||

|

|

||||||

|

=== "بيب تيكس"

|

||||||

|

|

||||||

|

```bibtex

|

||||||

|

@misc{zhao2023fast,

|

||||||

|

title={Fast Segment Anything},

|

||||||

|

author={Xu Zhao and Wenchao Ding and Yongqi An and Yinglong Du and Tao Yu and Min Li and Ming Tang and Jinqiao Wang},

|

||||||

|

year={2023},

|

||||||

|

eprint={2306.12156},

|

||||||

|

archivePrefix={arXiv},

|

||||||

|

primaryClass={cs.CV}

|

||||||

|

}

|

||||||

|

```

|

||||||

|

|

||||||

|

يمكن العثور على ورقة FastSAM الأصلية على [arXiv](https://arxiv.org/abs/2306.12156). قام الأباء بجعل أعمالهم متاحة للجمهور ، ويمكن الوصول إلى قاعدة الكود على [GitHub](https://github.com/CASIA-IVA-Lab/FastSAM). نقدر جهودهم في تطوير المجال وجعل أعمالهم متاحة للمجتمع الأوسع.

|

||||||

@ -1,93 +1,98 @@

|

|||||||

---

|

---

|

||||||

comments: true

|

comments: true

|

||||||

description: استكشف مجموعة متنوعة من عائلة YOLO، SAM، MobileSAM، FastSAM، YOLO-NAS ونماذج RT-DETR المدعومة بواسطة Ultralytics. ابدأ مع أمثلة للإستخدام باستخدام واجهة سطر الأوامر ولغة البايثون.

|

description: استكشف مجموعة متنوعة من عائلة YOLO، ونماذج SAM وMobileSAM وFastSAM وYOLO-NAS وRT-DETR المدعومة من Ultralytics. ابدأ بأمثلة لكل من استخدام واجهة الأوامر وPython.

|

||||||

keywords: Ultralytics، مستندات، YOLO، SAM، MobileSAM، FastSAM، YOLO-NAS، RT-DETR، نماذج، هندسات، Python، CLI

|

keywords: Ultralytics, documentation, YOLO, SAM, MobileSAM, FastSAM, YOLO-NAS, RT-DETR, models, architectures, Python, CLI

|

||||||

---

|

---

|

||||||

|

|

||||||

# النماذج المدعومة بواسطة Ultralytics

|

# النماذج المدعومة من Ultralytics

|

||||||

|

|

||||||

مرحبًا بك في مستندات نماذج Ultralytics! نحن نقدم دعمًا لمجموعة واسعة من النماذج، وكل نموذج مصمم لمهام محددة مثل [كشف الكائنات](../tasks/detect.md)، [تجزئة الحالات](../tasks/segment.md)، [تصنيف الصور](../tasks/classify.md)، [تقدير الوضع](../tasks/pose.md)، و[تتبع العديد من الكائنات](../modes/track.md). إذا كنت مهتمًا بالمساهمة في بنية نموذجك في Ultralytics ، تحقق من [دليل المساهمة](../../help/contributing.md).

|

أهلاً بك في وثائق نماذج Ultralytics! نحن نقدم الدعم لمجموعة واسعة من النماذج، كل منها مُصمم لمهام محددة مثل [الكشف عن الأجسام](../tasks/detect.md)، [تقطيع الحالات](../tasks/segment.md)، [تصنيف الصور](../tasks/classify.md)، [تقدير الوضعيات](../tasks/pose.md)، و[تتبع الأجسام المتعددة](../modes/track.md). إذا كنت مهتمًا بالمساهمة في هندسة نموذجك مع Ultralytics، راجع دليل [المساهمة](../../help/contributing.md).

|

||||||

|

|

||||||

!!! Note "ملاحظة"

|

!!! Note "ملاحظة"

|

||||||

|

|

||||||

🚧 مستنداتنا متعددة اللغات قيد الإنشاء حاليًا ونحن نعمل بجد لتحسينها. شكرا لك على صبرك! 🙏

|

🚧 تحت الإنشاء: وثائقنا بلغات متعددة قيد الإنشاء حاليًا، ونحن نعمل بجد لتحسينها. شكرًا لصبرك! 🙏

|

||||||

|

|

||||||

## النماذج المميزة

|

## النماذج المميزة

|

||||||

|

|

||||||

فيما يلي بعض النماذج الرئيسية المدعمة:

|

إليك بعض النماذج الرئيسية المدعومة:

|

||||||

|

|

||||||

1. **[YOLOv3](../../models/yolov3.md)**: الإصدار الثالث من عائلة نموذج YOLO، والذي أنشأه جوزيف ريدمون، والمعروف بقدرته على الكشف في الوقت الحقيقي بكفاءة.

|

1. **[YOLOv3](yolov3.md)**: الإصدار الثالث من عائلة نموذج YOLO، الذي أنشأه أصلاً Joseph Redmon، والمعروف بقدراته الفعالة في الكشف عن الأجسام في الوقت الفعلي.

|

||||||

2. **[YOLOv4](../../models/yolov4.md)**: تحديث لنموذج YOLOv3 الأصلي من قبل اليكسي بوتشكوفسكي في عام 2020.

|

2. **[YOLOv4](yolov4.md)**: تحديث محلي لـ YOLOv3، تم إصداره بواسطة Alexey Bochkovskiy في 2020.

|

||||||

3. **[YOLOv5](../../models/yolov5.md)**: إصدار محسن لبنية YOLO بواسطة Ultralytics ، يقدم أداءً أفضل وتفاوتات سرعة مقارنة بالإصدارات السابقة.

|

3. **[YOLOv5](yolov5.md)**: نسخة مُحسنة من هندسة YOLO من قبل Ultralytics، توفر أداءً أفضل وتوازن في السرعة مقارنة بالإصدارات السابقة.

|

||||||

4. **[YOLOv6](../../models/yolov6.md)**: تم إصداره بواسطة [ميتوان](https://about.meituan.com/) في عام 2022 ، ويستخدم في العديد من روبوتات التسليم الذاتي للشركة.

|

4. **[YOLOv6](yolov6.md)**: أُصدرت بواسطة [Meituan](https://about.meituan.com/) في 2022، ويُستخدم في العديد من روبوتات التوصيل الذاتية للشركة.

|

||||||

5. **[YOLOv7](../../models/yolov7.md)**: نماذج YOLO المحدثة التي تم إطلاقها في عام 2022 من قبل أصحاب YOLOv4.

|

5. **[YOLOv7](yolov7.md)**: تم إصدار نماذج YOLO المحدثة في 2022 بواسطة مؤلفي YOLOv4.

|

||||||

6. **[YOLOv8](../../models/yolov8.md)**: أحدث إصدار من عائلة YOLO ، ويتميز بقدرات محسنة مثل تجزئة الحالات، وتقدير النقاط الرئيسة، والتصنيف.

|

6. **[YOLOv8](yolov8.md) جديد 🚀**: الإصدار الأحدث من عائلة YOLO، يتميز بقدرات مُعززة مثل تقطيع الحالات، تقدير الوضعيات/النقاط الرئيسية، والتصنيف.

|

||||||

7. **[Segment Anything Model (SAM)](../../models/sam.md)**: نموذج Segment Anything Model (SAM) من Meta.

|

7. **[Segment Anything Model (SAM)](sam.md)**: نموذج Segment Anything Model (SAM) من Meta.

|

||||||

8. **[Mobile Segment Anything Model (MobileSAM)](../../models/mobile-sam.md)**: MobileSAM لتطبيقات الهواتف المحمولة ، من جامعة Kyung Hee.

|

8. **[Mobile Segment Anything Model (MobileSAM)](mobile-sam.md)**: نموذج MobileSAM للتطبيقات المحمولة، من جامعة Kyung Hee.

|

||||||

9. **[Fast Segment Anything Model (FastSAM)](../../models/fast-sam.md)**: FastSAM من مجموعة تحليل الصور والفيديو، معهد الأتمتة، الأكاديمية الصينية للعلوم.

|

9. **[Fast Segment Anything Model (FastSAM)](fast-sam.md)**: نموذج FastSAM من مجموعة تحليل الصور والفيديو، والمعهد الصيني للأتمتة، وأكاديمية العلوم الصينية.

|

||||||

10. **[YOLO-NAS](../../models/yolo-nas.md)**: نماذج YOLO للبحث في تصميم العمارة العصبية.

|

10. **[YOLO-NAS](yolo-nas.md)**: نماذج YOLO Neural Architecture Search (NAS).

|

||||||

11. **[Realtime Detection Transformers (RT-DETR)](../../models/rtdetr.md)**: نماذج PaddlePaddle Realtime Detection Transformer (RT-DETR) من Baidu.

|

11. **[Realtime Detection Transformers (RT-DETR)](rtdetr.md)**: نماذج Realtime Detection Transformer (RT-DETR) من PaddlePaddle التابعة لشركة Baidu.

|

||||||

|

|

||||||

<p align="center">

|

<p align="center">

|

||||||

<br>

|

<br>

|

||||||

<iframe width="720" height="405" src="https://www.youtube.com/embed/MWq1UxqTClU?si=nHAW-lYDzrz68jR0"

|

<iframe width="720" height="405" src="https://www.youtube.com/embed/MWq1UxqTClU?si=nHAW-lYDzrz68jR0"

|

||||||

title="YouTube video player" frameborder="0"

|

title="مشغل فيديو YouTube" frameborder="0"

|

||||||

allow="accelerometer; autoplay; clipboard-write; encrypted-media; gyroscope; picture-in-picture; web-share"

|

allow="accelerometer; autoplay; clipboard-write; encrypted-media; gyroscope; picture-in-picture; web-share"

|

||||||

allowfullscreen>

|

allowfullscreen>

|

||||||

</iframe>

|

</iframe>

|

||||||

<br>

|

<br>

|

||||||

<strong>شاهد:</strong> قم بتشغيل نماذج Ultralytics YOLO في بضعة أسطر من الكود.

|

<strong>شاهد:</strong> تشغيل نماذج YOLO من Ultralytics في بضعة أسطر من الكود فقط.

|

||||||

</p>

|

</p>

|

||||||

|

|

||||||

## البدء: أمثلة للإستخدام

|

## البدء في الاستخدام: أمثلة على الاستخدام

|

||||||

|

|

||||||

|

يوفر هذا المثال أمثلة مبسطة على التدريب والاستدلال باستخدام YOLO. للحصول على الوثائق الكاملة عن هذه وغيرها من [الأوضاع](../modes/index.md), انظر صفحات وثائق [التنبؤ](../modes/predict.md)، و[التدريب](../modes/train.md)، و[التقييم](../modes/val.md) و[التصدير](../modes/export.md).

|

||||||

|

|

||||||

|

لاحظ أن المثال أدناه هو لنماذج [Detect](../tasks/detect.md) YOLOv8 لكشف الأجسام. للاطلاع على المهام الإضافية المدعومة، راجع وثائق [Segment](../tasks/segment.md)، و[Classify](../tasks/classify.md) و[Pose](../tasks/pose.md).

|

||||||

|

|

||||||

!!! Example "مثال"

|

!!! Example "مثال"

|

||||||

|

|

||||||

=== "Python"

|

=== "Python"

|

||||||

|

|

||||||

يمكن تمرير نماذج PyTorch مدربة سابقًا بتنسيق `*.pt` بالإضافة إلى ملفات التكوين بتنسيق `*.yaml` إلى فئات `YOLO()`، `SAM()`، `NAS()` و `RTDETR()` لإنشاء نموذج في Python:

|

نماذج `*.pt` المُدربة مسبقًا وملفات الإعداد `*.yaml` يمكن أن تُمرر إلى فئات `YOLO()`, `SAM()`, `NAS()` و `RTDETR()` لإنشاء مثال نموذج في Python:

|

||||||

|

|

||||||

```python

|

```python

|

||||||

from ultralytics import YOLO

|

من ultralytics استيراد YOLO

|

||||||

|

|

||||||

# قم بتحميل نموذج YOLOv8n المدرب بـ COCO المسبق

|

# تحميل نموذج YOLOv8n المُدرب مسبقًا على COCO

|

||||||

model = YOLO('yolov8n.pt')

|

النموذج = YOLO('yolov8n.pt')

|

||||||

|

|

||||||

# عرض معلومات النموذج (اختياري)

|

# عرض معلومات النموذج (اختياري)

|

||||||

model.info()

|

model.info()

|

||||||

|

|

||||||

# قم بتدريب النموذج على مجموعة بيانات COCO8 لمدة 100 حقبة

|

# تدريب النموذج على مجموعة البيانات المثالية COCO8 لمدة 100 عصر

|

||||||

results = model.train(data='coco8.yaml', epochs=100, imgsz=640)

|

النتائج = model.train(data='coco8.yaml', epochs=100, imgsz=640)

|

||||||

|

|

||||||

# قم بتشغيل الاستدلال مع نموذج YOLOv8n على صورة 'bus.jpg'

|

# تشغيل الاستدلال بنموذج YOLOv8n على صورة 'bus.jpg'

|

||||||

results = model('path/to/bus.jpg')

|

النتائج = model('path/to/bus.jpg')

|

||||||

```

|

```

|

||||||

|

|

||||||

=== "CLI"

|

=== "CLI"

|

||||||

|

|

||||||

هناك أوامر CLI متاحة لتشغيل النماذج مباشرةً:

|

الأوامر CLI متاحة لتشغيل النماذج مباشرة:

|

||||||

|

|

||||||

```bash

|

```bash

|

||||||

# قم بتحميل نموذج YOLOv8n المدرب بـ COCO المسبق و تدريبه على مجموعة بيانات COCO8 لمدة 100 حقبة

|

# تحميل نموذج YOLOv8n المُدرب مسبقًا على COCO وتدريبه على مجموعة البيانات المثالية COCO8 لمدة 100 عصر

|

||||||

yolo train model=yolov8n.pt data=coco8.yaml epochs=100 imgsz=640

|

yolo train model=yolov8n.pt data=coco8.yaml epochs=100 imgsz=640

|

||||||

|

|

||||||

# قم بتحميل نموذج YOLOv8n المدرب بـ COCO المسبق و قم بتشغيل الاستدلال على صورة 'bus.jpg'

|

# تحميل نموذج YOLOv8n المُدرب مسبقًا على COCO وتشغيل الاستدلال على صورة 'bus.jpg'

|

||||||

yolo predict model=yolov8n.pt source=path/to/bus.jpg

|

yolo predict model=yolov8n.pt source=path/to/bus.jpg

|

||||||

```

|

```

|

||||||

|

|

||||||

## المساهمة في نماذج جديدة

|

## المساهمة بنماذج جديدة

|

||||||

|

|

||||||

هل ترغب في المساهمة بنموذجك في Ultralytics؟ رائع! نحن مفتوحون دائمًا لتوسيع مجموعة النماذج الخاصة بنا.

|

هل أنت مهتم بالمساهمة بنموذجك في Ultralytics؟ رائع! نحن دائمًا منفتحون على توسيع محفظة النماذج لدينا.

|

||||||

|

|

||||||

1. **انسخ المستودع**: ابدأ بإنشاء فرع جديد في مستودع [Ultralytics GitHub repository ](https://github.com/ultralytics/ultralytics).

|

1. **احفظ نسخة عن المستودع**: ابدأ بحفظ نسخة عن [مستودع Ultralytics على GitHub](https://github.com/ultralytics/ultralytics).

|

||||||

|

|

||||||

2. **نسخ Fork الخاص بك**: نسخ Fork الخاص بك إلى جهاز الكمبيوتر المحلي الخاص بك وأنشئ فرعًا جديدًا للعمل عليه.

|

2. **استنسخ نسختك**: انسخ نسختك إلى جهازك المحلي وأنشئ فرعًا جديدًا للعمل عليه.

|

||||||

|

|

||||||

3. **اتبع نموذجك**: قم بإضافة نموذجك وفقًا لمعايير البرمجة والتوجيهات المقدمة في [دليل المساهمة](../../help/contributing.md).

|

3. **طبق نموذجك**: أضف نموذجك متبعًا معايير وإرشادات البرمجة الموفرة في دليل [المساهمة](../../help/contributing.md) لدينا.

|

||||||

|

|

||||||

4. **اختبر بدقة**: تأكد من اختبار نموذجك بدقة ، سواء بشكل منفصل أم كجزء من السلسلة.

|

4. **اختبر بدقة**: تأكد من اختبار نموذجك بشكل مكثف، سواء بشكل منفصل أو كجزء من المسار البرمجي.

|

||||||

|

|

||||||

5. **أنشئ طلبًا للدمج**: بمجرد أن تكون راضيًا عن نموذجك، قم بإنشاء طلب للدمج إلى البرنامج الرئيسي للمراجعة.

|

5. **أنشئ Pull Request**: بمجرد أن تكون راضًيا عن نموذجك، قم بإنشاء طلب سحب إلى المستودع الرئيسي للمراجعة.

|

||||||

|

|

||||||

6. **استعراض ودمج الكود**: بعد المراجعة، إذا كان نموذجك يلبي معاييرنا، فسيتم دمجه في البرنامج الرئيسي.

|

6. **مراجعة الكود والدمج**: بعد المراجعة، إذا كان نموذجك يلبي معاييرنا، سيتم دمجه في المستودع الرئيسي.

|

||||||

|

|

||||||

للخطوات المفصلة ، استشر [دليل المساهمة](../../help/contributing.md).

|

للخطوات التفصيلية، يرجى الرجوع إلى دليل [المساهمة](../../help/contributing.md).

|

||||||

|

|||||||

116

docs/ar/models/mobile-sam.md

Normal file

116

docs/ar/models/mobile-sam.md

Normal file

@ -0,0 +1,116 @@

|

|||||||

|

---

|

||||||

|

comments: true

|

||||||

|

description: تعرّف على MobileSAM وتطبيقه، وقارنه مع SAM الأصلي، وكيفية تنزيله واختباره في إطار Ultralytics. قم بتحسين تطبيقاتك المحمولة اليوم.

|

||||||

|

keywords: MobileSAM، Ultralytics، SAM، التطبيقات المحمولة، Arxiv، GPU، API، مُشفّر الصورة، فك تشفير القناع، تنزيل النموذج، طريقة الاختبار

|

||||||

|

---

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

# التمييز المحمول لأي شيء (MobileSAM)

|

||||||

|

|

||||||

|

الآن يمكنك الاطّلاع على ورقة MobileSAM في [arXiv](https://arxiv.org/pdf/2306.14289.pdf).

|

||||||

|

|

||||||

|

يمكن الوصول إلى عرض مباشر لـ MobileSAM يعمل على وحدة المعالجة المركزية CPU من [هنا](https://huggingface.co/spaces/dhkim2810/MobileSAM). يستغرق الأداء على وحدة المعالجة المركزية Mac i5 تقريبًا 3 ثوانٍ. في عرض الواجهة التفاعلية الخاص بهنغ فيس، تؤدي واجهة المستخدم ووحدات المعالجة المركزية ذات الأداء المنخفض إلى استجابة أبطأ، لكنها تواصل العمل بفعالية.

|

||||||

|

|

||||||

|

تم تنفيذ MobileSAM في عدة مشاريع بما في ذلك [Grounding-SAM](https://github.com/IDEA-Research/Grounded-Segment-Anything) و [AnyLabeling](https://github.com/vietanhdev/anylabeling) و [Segment Anything in 3D](https://github.com/Jumpat/SegmentAnythingin3D).

|

||||||

|

|

||||||

|

تم تدريب MobileSAM على وحدة المعالجة الرسومية (GPU) الواحدة باستخدام مجموعة بيانات تحتوي على 100000 صورة (1% من الصور الأصلية) في أقل من يوم واحد. سيتم توفير الشفرة المصدرية لعملية التدريب هذه في المستقبل.

|

||||||

|

|

||||||

|

## النماذج المتاحة، المهام المدعومة، وأوضاع التشغيل

|

||||||

|

|

||||||

|

يُعرض في هذا الجدول النماذج المتاحة مع وزنها المدرب مسبقًا، والمهام التي تدعمها، وتوافقها مع أوضاع التشغيل المختلفة مثل [الاستدلال](../modes/predict.md)، [التحقق](../modes/val.md)، [التدريب](../modes/train.md)، و [التصدير](../modes/export.md)، حيث يُشير إيموجي ✅ للأوضاع المدعومة وإيموجي ❌ للأوضاع غير المدعومة.

|

||||||

|

|

||||||

|

| نوع النموذج | الأوزان المدربة مسبقًا | المهام المدعومة | الاستدلال | التحقق | التدريب | التصدير |

|

||||||

|

|-------------|------------------------|--------------------------------------|-----------|--------|---------|---------|

|

||||||

|

| MobileSAM | `mobile_sam.pt` | [تجزئة العناصر](../tasks/segment.md) | ✅ | ❌ | ❌ | ✅ |

|

||||||

|

|

||||||

|

## التحويل من SAM إلى MobileSAM

|

||||||

|

|

||||||

|

نظرًا لأن MobileSAM يحتفظ بنفس سير العمل لـ SAM الأصلي، قمنا بدمج التجهيزات المسبقة والتجهيزات اللاحقة للنموذج الأصلي وجميع الواجهات الأخرى. نتيجة لذلك، يمكن لأولئك الذين يستخدمون حاليًا SAM الأصلي الانتقال إلى MobileSAM بقدر أدنى من الجهد.

|

||||||

|

|

||||||

|

يؤدي MobileSAM بشكل مقارب لـ SAM الأصلي ويحتفظ بنفس سير العمل باستثناء تغيير في مُشفر الصورة. على وحدة المعالجة الرسومية (GPU) الواحدة، يعمل MobileSAM بمعدل 12 مللي ثانية لكل صورة: 8 مللي ثانية لمُشفر الصورة و4 مللي ثانية لفك تشفير القناع.

|

||||||

|

|

||||||

|

يوفر الجدول التالي مقارنة بين مُشفرات الصور القائمة على ViT:

|

||||||

|

|

||||||

|

| مُشفّر الصورة | SAM الأصلي | MobileSAM |

|

||||||

|

|---------------|----------------|--------------|

|

||||||

|

| العوامل | 611 مليون | 5 مليون |

|

||||||

|

| السرعة | 452 مللي ثانية | 8 مللي ثانية |

|

||||||

|

|

||||||

|

يستخدم SَM الأصلي و MobileSAM نفس فك تشفير القناع الذي يعتمد على التوجيه بواسطة الرموز:

|

||||||

|

|

||||||

|

| فك تشفير القناع | SAM الأصلي | MobileSAM |

|

||||||

|

|-----------------|--------------|--------------|

|

||||||

|

| العوامل | 3.876 مليون | 3.876 مليون |

|

||||||

|

| السرعة | 4 مللي ثانية | 4 مللي ثانية |

|

||||||

|

|

||||||

|

فيما يلي مقارنة لكامل سير العمل:

|

||||||

|

|

||||||

|

| السير الكامل (التشفير+الفك) | SAM الأصلي | MobileSAM |

|

||||||

|

|-----------------------------|----------------|---------------|

|

||||||

|

| العوامل | 615 مليون | 9.66 مليون |

|

||||||

|

| السرعة | 456 مللي ثانية | 12 مللي ثانية |

|

||||||

|

|

||||||

|

يتم عرض أداء MobileSAM و SAM الأصلي باستخدام كل من النقطة ومربع كلمة المحفز.

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

بفضل أدائه المتفوق، يكون MobileSAM أصغر بحوالي 5 أضعاف وأسرع بحوالي 7 أضعاف من FastSAM الحالي. يتوفر مزيد من التفاصيل على [صفحة مشروع MobileSAM](https://github.com/ChaoningZhang/MobileSAM).

|

||||||

|

|

||||||

|

## اختبار MobileSAM في Ultralytics

|

||||||

|

|

||||||

|

مثل SAM الأصلي، نقدم طريقة اختبار مبسّطة في Ultralytics، بما في ذلك وضعي النقطة والصندوق.

|

||||||

|

|

||||||

|

### تنزيل النموذج

|

||||||

|

|

||||||

|

يمكنك تنزيل النموذج [هنا](https://github.com/ChaoningZhang/MobileSAM/blob/master/weights/mobile_sam.pt).

|

||||||

|

|

||||||

|

### النقطة ككلمة محفز

|

||||||

|

|

||||||

|

!!! Example "مثال"

|

||||||

|

|

||||||

|

=== "Python"

|

||||||

|

```python

|

||||||

|

from ultralytics import SAM

|

||||||

|

|

||||||

|

# تحميل النموذج

|

||||||

|

model = SAM('mobile_sam.pt')

|

||||||

|

|

||||||

|

# توقع جزء بناءً على نقطة محفز

|

||||||

|

model.predict('ultralytics/assets/zidane.jpg', points=[900, 370], labels=[1])

|

||||||

|

```

|

||||||

|

|

||||||

|

### الصندوق ككلمة محفز

|

||||||

|

|

||||||

|

!!! Example "مثال"

|

||||||

|

|

||||||

|

=== "Python"

|

||||||

|

```python

|

||||||

|

from ultralytics import SAM

|

||||||

|

|

||||||

|

# تحميل النموذج

|

||||||

|

model = SAM('mobile_sam.pt')

|

||||||

|

|

||||||

|

# توقع جزء بناءً على صندوق محفز

|

||||||

|

model.predict('ultralytics/assets/zidane.jpg', bboxes=[439, 437, 524, 709])

|

||||||

|

```

|

||||||

|

|

||||||

|

لقد قمنا بتنفيذ "MobileSAM" و "SAM" باستخدام نفس API. لمزيد من معلومات الاستخدام، يُرجى الاطّلاع على [صفحة SAM](sam.md).

|

||||||

|

|

||||||

|

## الاقتباس والشكر

|

||||||

|

|

||||||

|

إذا وجدت MobileSAM مفيدًا في أبحاثك أو عملك التطويري، يُرجى النظر في استشهاد ورقتنا:

|

||||||

|

|

||||||

|

!!! Quote ""

|

||||||

|

|

||||||

|

=== "BibTeX"

|

||||||

|

|

||||||

|

```bibtex

|

||||||

|

@article{mobile_sam,

|

||||||

|

title={Faster Segment Anything: Towards Lightweight SAM for Mobile Applications},

|

||||||

|

author={Zhang, Chaoning and Han, Dongshen and Qiao, Yu and Kim, Jung Uk and Bae, Sung Ho and Lee, Seungkyu and Hong, Choong Seon},

|

||||||

|

journal={arXiv preprint arXiv:2306.14289},

|

||||||

|

year={2023}

|

||||||

|

}

|

||||||

93

docs/ar/models/rtdetr.md

Normal file

93

docs/ar/models/rtdetr.md

Normal file

@ -0,0 +1,93 @@

|

|||||||

|

---

|

||||||

|

comments: true

|

||||||

|

description: اكتشف ميزات وفوائد RT-DETR من Baidu، وهو كاشف كائنات فعال وقابل للتكيف في الوقت الفعلي يعتمد على Vision Transformers، بما في ذلك النماذج المدربة مسبقًا.

|

||||||

|

keywords: RT-DETR, Baidu, Vision Transformers, كشف كائنات, أداء فوري, CUDA, TensorRT, اختيار الاستعلام المرتبط بـ IoU, Ultralytics, واجهة برمجة التطبيقات الخاصة بلغة Python, PaddlePaddle

|

||||||

|

---

|

||||||

|

|

||||||

|

# RT-DETR من Baidu: اكتشاف كائنات في الوقت الفعلي يعتمد على Vision Transformer

|

||||||

|

|

||||||

|

## النظرة العامة

|

||||||

|

|

||||||

|

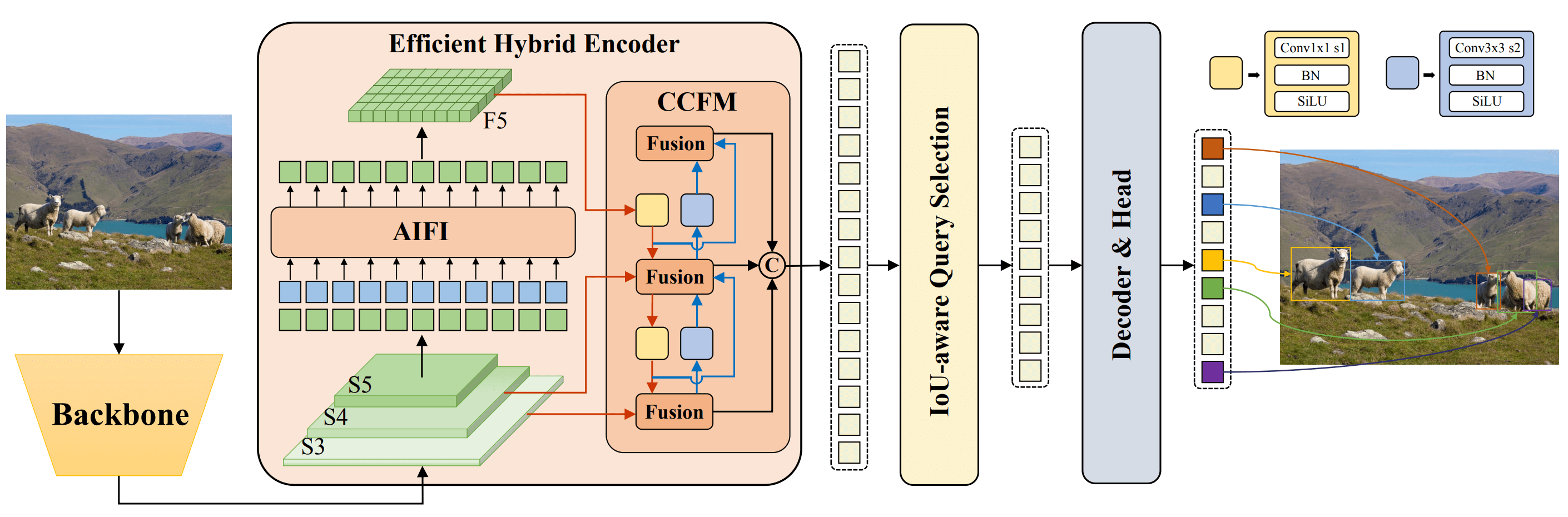

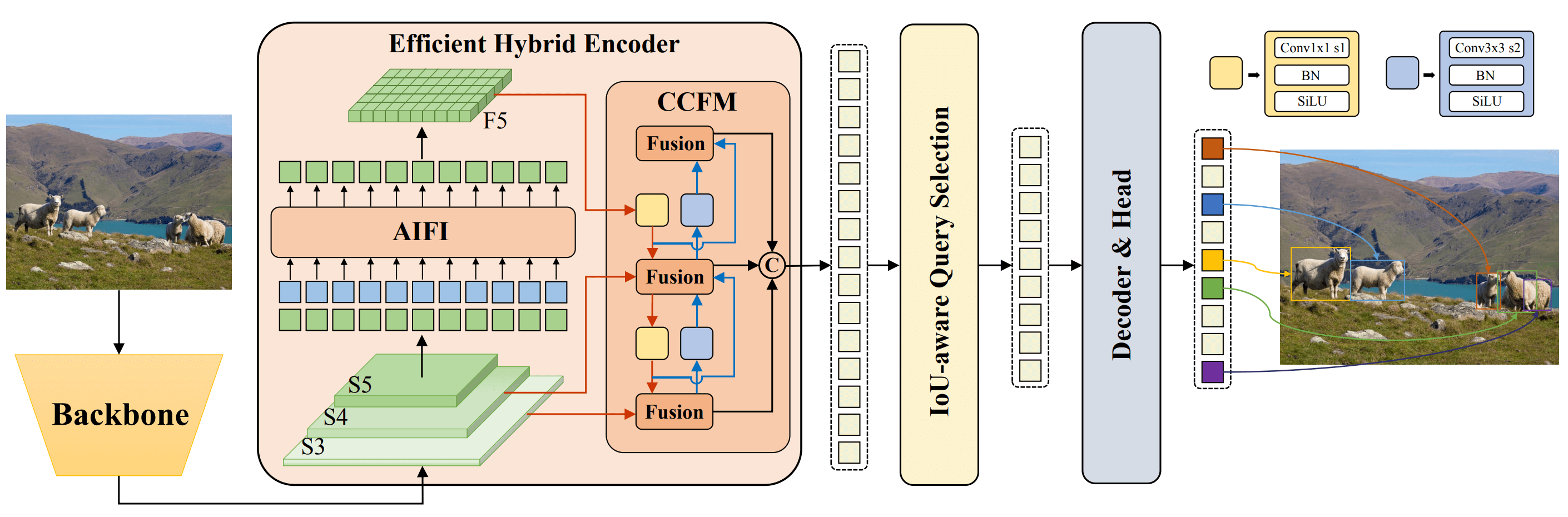

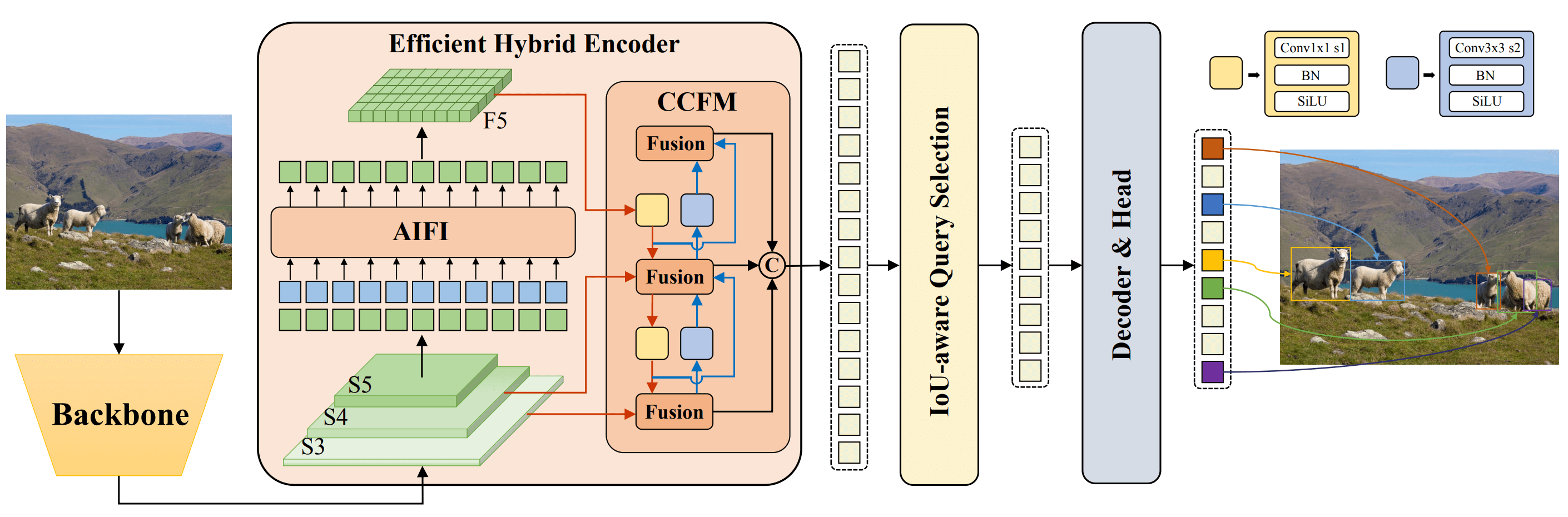

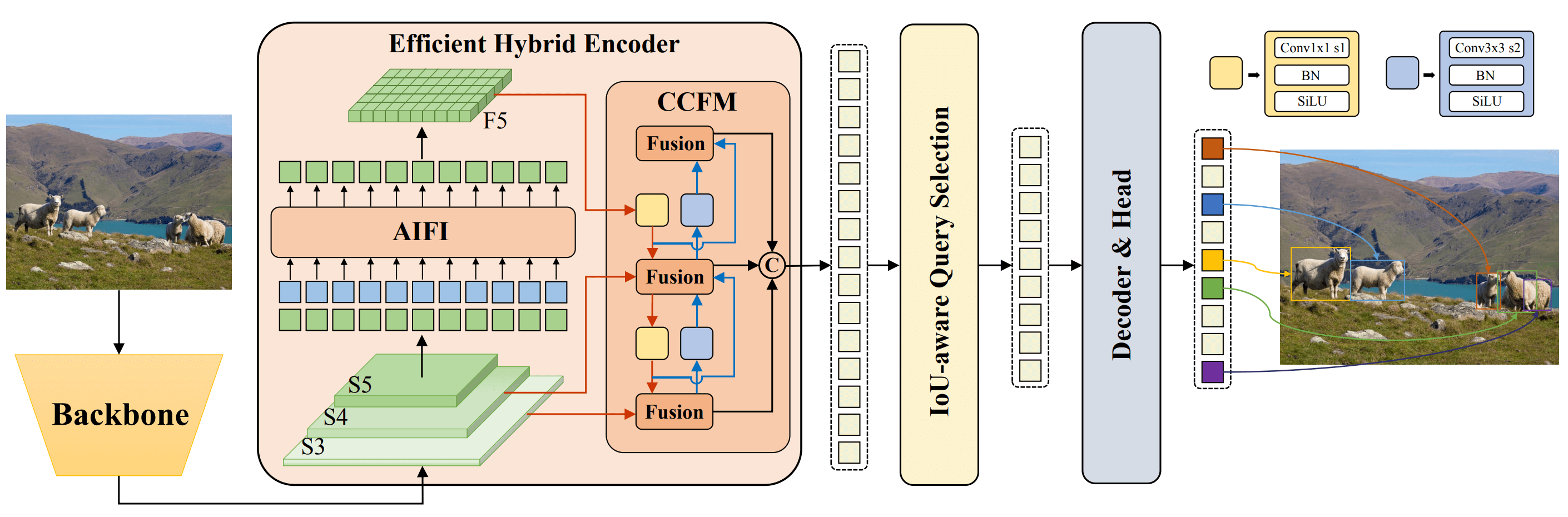

Real-Time Detection Transformer (RT-DETR)، المطور من قبل Baidu، هو كاشف حديث الطراز يوفر أداءً فعليًا في الوقت الفعلي مع الحفاظ على دقة عالية. يستفيد من قوة Vision Transformers (ViT) في معالجة الميزات متعددة المقياس عن طريق فصل التفاعلات داخل المقياس ودمج التفاعلات بين المقاييس المختلفة. يتكيف RT-DETR بشكل كبير ويدعم ضبط سرعة الاستعلام باستخدام طبقات مختلفة في المفكرة بدون إعادة التدريب. يتفوق هذا النموذج على العديد من كاشفات الكائنات في الوقت الفعلي الأخرى، ويستفيد من المنصات القوية مثل CUDA مع TensorRT.

|

||||||

|

|

||||||

|

|

||||||

|

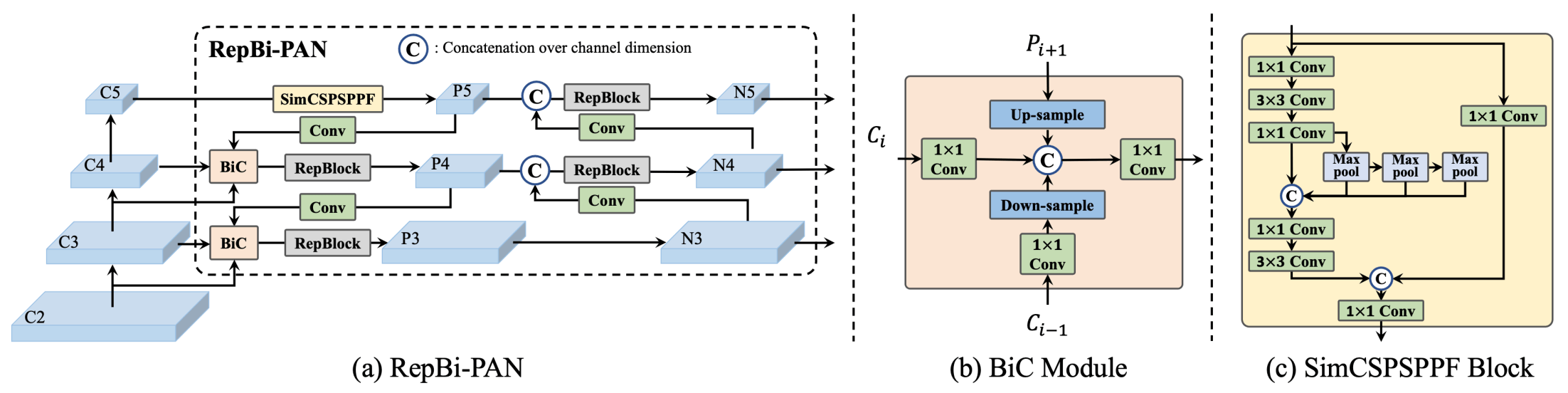

**نظرة عامة على RT-DETR من Baidu.** يعرض مخطط معمارية نموذج RT-DETR مراحل الظهر الثلاث الأخيرة {S3، S4، S5} كإدخال للمشفر. يحول المشفر الهجين الفعال الميزات متعددة المقياس إلى تسلسل من ميزات الصورة من خلال تفاعل الميزات داخل المقياس (AIFI) ووحدة دمج الميزات بين المقاييس المختلفة (CCFM). يتم استخدام اختيار الاستعلام المرتبط بـ IoU لاختيار عدد ثابت من ميزات الصورة لتكون استعلامات الكائن الأولية لفك الترميز. أخيرًا، يحسن فك الترميز مع رؤوس التنبؤ الإضافية الاستعلامات الكائنية لتوليد المربعات وتقييمات الثقة ([المصدر](https://arxiv.org/pdf/2304.08069.pdf)).

|

||||||

|

|

||||||

|

### الميزات الرئيسية

|

||||||

|

|

||||||

|

- **مشفر هجين فعال:** يستخدم RT-DETR من Baidu مشفر هجين فعال يعمل على معالجة الميزات متعددة المقياس من خلال فصل التفاعلات داخل المقياس ودمج التفاعلات بين المقاييس المختلفة. يقلل هذا التصميم الفريد القائم على Vision Transformers من تكاليف الحسابات ويتيح الكشف عن الكائنات في الوقت الفعلي.

|

||||||

|

- **اختيار الاستعلام المرتبط بـ IoU:** يعمل RT-DETR من Baidu على تحسين بدء استعلام الكائنات من خلال استخدام اختيار الاستعلام المرتبط بـ IoU. يتيح هذا للنموذج التركيز على الكائنات الأكثر صلة في السيناريو، مما يعزز دقة الكشف.

|

||||||

|

- **سرعة الاستنتاج قابلة للتكيف:** يدعم RT-DETR من Baidu ضبط سرعة الاستنتاج بشكل مرن باستخدام طبقات مختلفة في المفكرة دون الحاجة لإعادة التدريب. يسهل هذا التكيف التطبيق العملي في العديد من سيناريوهات كشف الكائنات في الوقت الفعلي.

|

||||||

|

|

||||||

|

## النماذج المدربة مسبقًا

|

||||||

|

|

||||||

|

تقدم واجهة برمجة التطبيقات الخاصة بلغة Python في Ultralytics نماذج PaddlePaddle RT-DETR مدربة مسبقًا بمقاييس مختلفة:

|

||||||

|

|

||||||

|

- RT-DETR-L: 53.0% AP على COCO val2017، 114 FPS على GPU T4

|

||||||

|

- RT-DETR-X: 54.8% AP على COCO val2017، 74 FPS على GPU T4

|

||||||

|

|

||||||

|

## أمثلة الاستخدام

|

||||||

|

|

||||||

|

يوفر هذا المثال أمثلة بسيطة لتدريب واختبار RT-DETRR. للحصول على وثائق كاملة حول هذه الأمثلة وأوضاع أخرى [انقر هنا](../modes/index.md) للاطلاع على صفحات الوثائق [التنبؤ](../modes/predict.md)، [التدريب](../modes/train.md)، [التصحيح](../modes/val.md) و [التصدير](../modes/export.md).

|

||||||

|

|

||||||

|

!!! Example "مثال"

|

||||||

|

|

||||||

|

=== "Python"

|

||||||

|

|

||||||

|

```python

|

||||||

|

from ultralytics import RTDETR

|

||||||

|

|

||||||

|

# تحميل نموذج RT-DETR-l محمي بواسطة COCO مسبقًا

|

||||||

|

model = RTDETR('rtdetr-l.pt')

|

||||||

|

|

||||||

|

# عرض معلومات النموذج (اختياري)

|

||||||

|

model.info()

|

||||||

|

|

||||||

|

# تدريب النموذج على مجموعة بيانات المثال COCO8 لـ 100 دورة

|

||||||

|

results = model.train(data='coco8.yaml', epochs=100, imgsz=640)

|

||||||

|

|

||||||

|

# تشغيل الاستدلال باستخدام النموذج RT-DETR-l على صورة 'bus.jpg'

|

||||||

|

results = model('path/to/bus.jpg')

|

||||||

|

```

|

||||||

|

|

||||||

|

=== "CLI"

|

||||||

|

|

||||||

|

```bash

|

||||||

|

# تحميل نموذج RT-DETR-l محمي بواسطة COCO مسبقًا وتدريبه على مجموعة بيانات المثال COCO8 لـ 100 دورة

|

||||||

|

yolo train model=rtdetr-l.pt data=coco8.yaml epochs=100 imgsz=640

|

||||||

|

|

||||||

|

# تحميل نموذج RT-DETR-l محمي بواسطة COCO مسبقًا وتشغيل الاستدلال على صورة 'bus.jpg'

|

||||||

|

yolo predict model=rtdetr-l.pt source=path/to/bus.jpg

|

||||||

|

```

|

||||||

|

|

||||||

|

## المهام والأوضاع المدعومة

|

||||||

|

|

||||||

|

يقدم هذا الجدول أنواع النماذج والأوزان المدربة مسبقًا المحددة والمهام المدعومة بواسطة كل نموذج، والأوضاع المختلفة ([التدريب](../modes/train.md)، [التصحيح](../modes/val.md)، [التنبؤ](../modes/predict.md)، [التصدير](../modes/export.md)) التي يتم دعمها، ممثلة برموز الـ ✅.

|

||||||

|

|

||||||

|

| نوع النموذج | الأوزان المدربة مسبقًا | المهام المدعومة | استنتاج | تحقق صحة | تدريب | استيراد |

|

||||||

|

|-----------------------|------------------------|----------------------------------|---------|----------|-------|---------|

|

||||||

|

| RT-DETR الكبير | `rtdetr-l.pt` | [كشف كائنات](../tasks/detect.md) | ✅ | ✅ | ✅ | ✅ |

|

||||||

|

| RT-DETR الكبير الزائد | `rtdetr-x.pt` | [كشف كائنات](../tasks/detect.md) | ✅ | ✅ | ✅ | ✅ |

|

||||||

|

|

||||||

|

## الاستشهادات والتقديرات

|

||||||

|

|

||||||

|

إذا استخدمت RT-DETR من Baidu في أعمال البحث أو التطوير الخاصة بك، يرجى الاستشهاد بـ [الورقة الأصلية](https://arxiv.org/abs/2304.08069):

|

||||||

|

|

||||||

|

!!! Quote ""

|

||||||

|

|

||||||

|

=== "BibTeX"

|

||||||

|

|

||||||

|

```bibtex

|

||||||

|

@misc{lv2023detrs,

|

||||||

|

title={DETRs Beat YOLOs on Real-time Object Detection},

|

||||||

|

author={Wenyu Lv and Shangliang Xu and Yian Zhao and Guanzhong Wang and Jinman Wei and Cheng Cui and Yuning Du and Qingqing Dang and Yi Liu},

|

||||||

|

year={2023},

|

||||||

|

eprint={2304.08069},

|

||||||

|

archivePrefix={arXiv},

|

||||||

|

primaryClass={cs.CV}

|

||||||

|

}

|

||||||

|

```

|

||||||

|

|

||||||

|

نحن نود أن نعرب عن امتناننا لـ Baidu وفريق [PaddlePaddle](https://github.com/PaddlePaddle/PaddleDetection) لإنشاء وصيانة هذ المورد القيم لمجتمع الرؤية الحاسوبية. نقدر تفاعلهم مع المجال من خلال تطوير كاشف الكائنات الحقيقي في الوقت الفعلي القائم على Vision Transformers، RT-DETR.

|

||||||

|

|

||||||

|

*keywords: RT-DETR، الناقل، Vision Transformers، Baidu RT-DETR، PaddlePaddle، Paddle Paddle RT-DETR، كشف كائنات في الوقت الفعلي، كشف كائنات قائم على Vision Transformers، نماذج PaddlePaddle RT-DETR مدربة مسبقًا، استخدام Baidu's RT-DETR، واجهة برمجة التطبيقات الخاصة بلغة Python في Ultralytics*

|

||||||

225

docs/ar/models/sam.md

Normal file

225

docs/ar/models/sam.md

Normal file

@ -0,0 +1,225 @@

|

|||||||

|

---

|

||||||

|

comments: true

|

||||||

|

description: استكشف النموذج القاطع للشيء أيا كان (SAM) الحديث من Ultralytics الذي يتيح الت segment تشفير صور الوقت الحقيقي. تعرف على مرونته في مجال الت segment، وأداء نقل انيفورم زيرو شوت، وكيفية استخدامه.

|

||||||

|

keywords: Ultralytics, قسيمة الصور, Segment Anything Model, SAM, سلسلة بيانات SA-1B, مرونة الصور في الوقت الحقيقي, نقل الانيفورم زيرو شوت, الكشف عن الكائنات, تحليل الصور, التعلم الآلي

|

||||||

|

---

|

||||||

|

|

||||||

|

# نموذج القطعة شيء ما (SAM)

|

||||||

|

|

||||||

|

مرحبًا بك في الجبهة الأولى لقطع الصور مع نموذج القطعة شيء ما ، أو SAM. هذا النموذج الثوري قد غير اللعبة من خلال إدخال التشفير القراءة للصور مع أداء في الوقت الحقيقي، وتحديد معايير جديدة في هذا المجال.

|

||||||

|

|

||||||

|

## مقدمة إلى SAM: القطعة شيء ما نموذج

|

||||||

|

|

||||||

|

نموذج القطعة شيء ما ، أو SAM، هو نموذج شفاف اول في فصل الصور الرقمية التي تتيح قدرة شهير على التشفير، توفر مرونة فريدة من نوعها في مهام التحليل اللازمة للصور. نموذج SAM هو أساس مشروع 'أي شيء في شيء' الابتكاري و هو مشروع يقدم نموذجا جديدا ، مهمة وسلسلة بيانات مبتكرة للفصل البصري.

|

||||||

|

|

||||||

|

يتيح تصميم SAM المتقدم له التكيف مع توزيعات صور جديدة ومهام جديدة دون الحاجة إلى معرفة مسبقة، وهذه الميزة تعرف بالكفاءة المطلوبة. حيث يتم تدريبه على سلسلة البيانات الواسعة [سلسلة SA-1B](https://ai.facebook.com/datasets/segment-anything/)، التي تحتوي على أكثر من ملياري قناع معروض على 11 مليون صورة تمت المحافظة عليها بعناية، وقد عرض SAM أداء مثير للإعجاب مع نقل انيفورم زيرو شوت فاق النتائج المراقبة السابقة بالتدريب الكامل في العديد من الحالات.

|

||||||

|

|

||||||

|

|

||||||

|

صور مثالية مع قناع محاط بها من سلسلة البيانات التي قدمناها حديثًا ، SA-1B. يحتوي سلسلة SA-1B على 11 مليون صورة متنوعة ، عالية الدقة ، مرخصة وتحمي الخصوصية و 1.1 مليار قناع فصل جودة عالية. تم توجيه هذه القناع تمامًا بتقويم آلي من قبل SAM وتم التحقق من جودتها وتنوعها من خلال تصنيفات بشرية وتجارب عديدة. يتم تجميع الصور حسب عدد الأقنعة في كل صورة للتصوير (هناك حوالي 100 قناع في الصورة في المتوسط).

|

||||||

|

|

||||||

|

## السمات الرئيسية لنموذج القطعة شيء ما (SAM)

|

||||||

|

|

||||||

|

- **مهمة التشفير القضائية:** تم تصميم SAM بهدف مهمة التشفير القابلة للتشفير ، مما يتيح له إنشاء قناع تشفير صالح من أي تلميح معين ، مثل الدلائل المكانية أو النصية التي تحدد الكائن.

|

||||||

|

- **بنية متقدمة:** يستخدم نموذج القطعة شيء ما مُشفر صورة قوي ، مشفر تشفير ومُشفر بسهولة الويغورة. تمكن هذه البنية الفريدة من فتح المجال للتشفير المرن ، وحساب القناع في الوقت الحقيقي ، والاستعداد للغموض في مهام التشفير.

|

||||||

|

- **سلسلة البيانات SA-1B:** التي قدمها مشروع أي شيء في شيء، تعرض سلسلة البيانات SA-1B أكثر من ملياري قناع على 11 مليون صورة. كأكبر سلسلة بيانات للفصل حتى الآن، توفر نموذج SAM مصدر تدريب ضخم ومتنوع.

|

||||||

|

- **أداء نقل الانيفورم زيرو شوت:** يعرض نموذج SAM أداء رائع في نقل الانيفورم زيرو شوت في مهام القطع المختلفة، مما يجعله أداة قوية جاهزة للاستخدام في تطبيقات متنوعة مع حاجة قليلة جدًا لهندسة التشفير الخاصة.

|

||||||

|

|

||||||

|

للحصول على نظرة شاملة على نموذج القطعة شيء ما وسلسلة SA-1B، يرجى زيارة [موقع أي شيء في شيء](https://segment-anything.com) واطلع على بحث [أي شيء في شيء](https://arxiv.org/abs/2304.02643).

|

||||||

|

|

||||||

|

## النماذج المتاحة والمهام المدعومة ووضعيات العمل

|

||||||

|

|

||||||

|

تقدم هذه الجدول النماذج المتاحة مع أوزان محددة مسبقًا والمهام التي يدعمونها وتوافقهم مع وضعيات العمل المختلفة مثل [قراءة الصورة](../modes/predict.md)، [التحقق](../modes/val.md)، [التدريب](../modes/train.md)، و [التصدير](../modes/export.md) ، مما يشير إلى ✅ رموز الدعم و ❌ للوضعيات غير المدعومة.

|

||||||

|

|

||||||

|

| نوع النموذج | الأوزان المدربة مسبقًا | المهام المدعومة | قراءة الصورة | التحقق | التدريب | التصدير |

|

||||||

|

|-------------|------------------------|------------------------------------|--------------|--------|---------|---------|

|

||||||

|

| SAM الأساسي | `sam_b.pt` | [تجزئة النسخ](../tasks/segment.md) | ✅ | ❌ | ❌ | ✅ |

|

||||||

|

| SAM الكبير | `sam_l.pt` | [تجزئة النسخ](../tasks/segment.md) | ✅ | ❌ | ❌ | ✅ |

|

||||||

|

|

||||||

|

## كيفية استخدام SAM: مرونة وقوة في تجزئة الصورة

|

||||||

|

|

||||||

|

يمكن استخدام نموذج القطعة شيء من أجل العديد من المهام التابعة إلى تدريبه. يشمل ذلك الكشف عن الحافة، إنشاء ترشيح للكائنات، تجزئة نسخة وتوقع نص مبدئي للتشفير. مع التشفير المهني ، يمكن لـ SAM التكيف بسرعة مع المهمات وتوزيعات البيانات الجديدة بطريقة transfer zero-shot، وبالتالي يعتبر أداة متعددة الاستخدامات وفعالة لجميع احتياجات تجزئة الصورة.

|

||||||

|

|

||||||

|

### مثال لدمج SAM

|

||||||

|

|

||||||

|

!!! Example "القسم بالاشارات"

|

||||||

|

|

||||||

|

تقسيم الصورة مع الإشارات المعطاة.

|

||||||

|

|

||||||

|

=== "البايثون"

|

||||||

|

|

||||||

|

```python

|

||||||

|

from ultralytics import SAM

|

||||||

|

|

||||||

|

# تحميل النموذج

|

||||||

|

model = SAM('sam_b.pt')

|

||||||

|

|

||||||

|

# عرض معلومات النموذج (اختياري)

|

||||||

|

model.info()

|

||||||

|

|

||||||

|

# تشغيل التنبوء بواسطة الدلائل

|

||||||

|

model('ultralytics/assets/zidane.jpg', bboxes=[439, 437, 524, 709])

|

||||||

|

|

||||||

|

# تشغيل التنبوء بواسطة نقاط الإشارة

|

||||||

|

model('ultralytics/assets/zidane.jpg', points=[900, 370], labels=[1])

|

||||||

|

```

|

||||||

|

|

||||||

|

!!! Example "قطع كل الشيء"

|

||||||

|

|

||||||

|

قم بتجزئة الصورة بأكملها.

|

||||||

|

|

||||||

|

=== "البايثون"

|

||||||

|

|

||||||

|

```python

|

||||||

|

from ultralytics import SAM

|

||||||

|

|

||||||

|

# تحميل النموذج

|

||||||

|

model = SAM('sam_b.pt')

|

||||||

|

|

||||||

|

# عرض معلومات النموذج (اختياري)

|

||||||

|

model.info()

|

||||||

|

|

||||||

|

# تشغيل التنبوء

|

||||||

|

model('مسار/إلى/صورة.jpg')

|

||||||

|

```

|

||||||

|

|

||||||

|

=== "صفيحة"

|

||||||

|

|

||||||

|

```البايش

|

||||||

|

# تشغيل التنبوء بنموذج SAM

|

||||||

|

yolo predict model=sam_b.pt source=path/to/image.jpg

|

||||||

|

```

|

||||||

|

|

||||||

|

- المنطق هنا هو تجزئة الصورة كلها إذا لم تمر عبر أي إشارات (bboxes/ points / masks).

|

||||||

|

|

||||||

|

!!! Example "مثال على SAMPredictor"

|

||||||

|

|

||||||

|

بواسطة هذا الطريق ، يمكنك تعيين الصورة مرة واحدة وتشغيل الإشارات مرارًا وتكرارًا دون تشغيل مشفر الصورة مرة أخرى.

|

||||||

|

|

||||||

|

=== "التنبؤ بالإشارة"

|

||||||

|

|

||||||

|

```البايثون

|

||||||

|

from ultralytics.models.sam import Predictor as SAMPredictor

|

||||||

|

|

||||||

|

# إنشاء SAMPredictor

|

||||||

|

الأعلى = dict (الثقة = 0.25، task ='segment'، النمط = 'تنبؤ'، imgsz = 1024، نموذج = "mobile_sam.pt")

|

||||||

|

predictor = SAMPredictor (overrides = التجاوز الأعلى)

|

||||||

|

|

||||||

|

# تعيين الصورة

|

||||||

|

predictor.set_image("ultralytics/assets/zidane.jpg") # تعيين بواسطة ملف صورة

|

||||||

|

predictor.set_image(cv2.imread("ultralytics/assets/zidane.jpg")) # تعيين مع np.ndarray

|

||||||

|

results = predictor(bboxes=[439, 437, 524, 709])

|

||||||

|

results = predictor(points=[900, 370], labels=[1])

|

||||||

|

|

||||||

|

# إعادة تعيين الصورة

|

||||||

|

predictor.reset_image()

|

||||||

|

```

|

||||||

|

|

||||||

|

قطع كل شيء مع وجود معطيات اختيارية.

|

||||||

|

|

||||||

|

=== "تقطيع كل شيء"

|

||||||

|

|

||||||

|

```البايثون

|

||||||

|

from ultralytics.models.sam import Predictor as SAMPredictor

|

||||||

|

|

||||||

|

# إنشاء SAMPredictor

|

||||||

|

الأعلى = dict (الثقة = 0.25، task ='segment'، النمط = 'تنبؤ'، imgsz = 1024، نموذج = "mobile_sam.pt")

|

||||||

|

predictor = SAMPredictor (overrides = التجاوز الأعلى)

|

||||||

|

|

||||||

|

# تجزئة مع بيانات إضافية

|

||||||

|

results = predictor(source="ultralytics/assets/zidane.jpg"، crop_n_layers=1، points_stride=64)

|

||||||

|

```

|

||||||

|

|

||||||

|

- المزيد args إضافي للتقطيع كل شيء شاهد التوثيق مرجع [`السلبي/تقديم` مرجع](../../reference/models/sam/predict.md).

|

||||||

|

|

||||||

|

## مقارنة SAM مقابل YOLOv8

|

||||||

|

|

||||||

|

في هذا المكان نقارن نموذج SAM الأصغر سام، SAM-b ، مع نموذج التجزئة YOLOv8 الصغيرة Ultralytics، [YOLOv8n-seg](../tasks/segment.md):

|

||||||

|

|

||||||

|

| النموذج | الحجم | المعلمات | السرعة (المعالج) |

|

||||||

|

|----------------------------------------------|----------------------------|-----------------------|--------------------------|

|

||||||

|

| سام SAM-b | 358 م.بايت | 94.7 M | 51096 ms/im |

|

||||||

|

| [MobileSAM](mobile-sam.md) | 40.7 MB | 10.1 M | 46122 ms/im |

|

||||||

|

| [FastSAM-s](fast-sam.md) with YOLOv8 حافظة | 23.7 MB | 11.8 M | 115 ms/im |

|

||||||

|

| [YOLOv8n-seg](../tasks/segment.md) ل Ultraly | **6.7 MB** (53.4 مرة أصغر) | **3.4 M** (27.9x أقل) | **59 ms/im** (866x أسرع) |

|

||||||

|

|

||||||

|

هذه المقارنة تظهر الاختلافات في أمر المقدار والسرعة بين النماذج. في حين يقدم SAM قدرات فريدة للتجزئة التلقائية ، إلا أنه ليس منافسًا مباشرًا لنماذج التجزئة YOLOv8 ، حيث تكون أصغر وأسرع وأكثر كفاءة.

|

||||||

|

|

||||||

|

اكتنزات التجريب على ماكينة Apple M2 Macbook 2023 مع 16GB من الذاكرة. لإعادة إنتاج هذا الاختبار:

|

||||||

|

|

||||||

|

!!! Example "مثال"

|

||||||

|

|

||||||

|

=== "البايثون"

|

||||||

|

```البايثون

|

||||||

|

from ultralytics import FastSAM, SAM, YOLO

|

||||||

|

|

||||||

|

# تحليل يام-b

|

||||||

|

model = SAM('sam_b.pt')

|

||||||

|

model.info()

|

||||||

|

model('ultralytics/assets')

|

||||||

|

|

||||||

|

# تحليل MobileSAM

|

||||||

|

model = SAM('mobile_sam.pt')

|

||||||

|

model.info()

|

||||||

|

model('ultralytics/assets')

|

||||||

|

|

||||||

|

# تحليل FastSAM-s

|

||||||

|

model = FastSAM('FastSAM-s.pt')

|

||||||

|

model.info()

|

||||||

|

model('ultralytics/assets')

|

||||||

|

|

||||||

|

# تحليل YOLOv8n-seg

|

||||||

|

model = YOLO('yolov8n-seg.pt')

|

||||||

|

model.info()

|

||||||

|

model('ultralytics/assets')

|

||||||

|

```

|

||||||

|

|

||||||

|

## تعلم تلقائي: مسار سريع إلى سلاسل البيانات الخاصة بالتجزئة

|

||||||

|

|

||||||

|

التعلم التلقائي هو ميزة رئيسية لـ SAM، حيث يسمح للمستخدمين بإنشاء [سلاسل بيانات تجزئة](https://docs.ultralytics.com/datasets/segment) باستخدام نموذج الكشف الجاهز. يتيح هذا الميزة إنشاء وتحديث سريع ودقيق لعدد كبير من الصور بدون الحاجة إلى عملية التسمية اليدوية البطيئة.

|

||||||

|

|

||||||

|

### إنشاء سلاسل البيانات الخاصة بالتجزئة باستخدام نموذج الكشف

|

||||||

|

|

||||||

|

للتعليم التلقائي لسلاسل البيانات الخاصة بالتجزئة باستخدام إطار العمل Ultralytics ، استخدم وظيفة 'auto_annotate' كما هو موضح أدناه:

|

||||||

|

|

||||||

|

!!! Example "مثال"

|

||||||

|

|

||||||

|

=== "البايثون"

|

||||||

|

```البايثون

|

||||||

|

from ultralytics.data.annotator import auto_annotate

|

||||||

|

|

||||||

|

auto_annotate(data="مسار/إلى/صور", det_model="yolov8x.pt", sam_model='sam_b.pt')

|

||||||

|

```

|

||||||

|

|

||||||

|

| الوسيطة | النوع | الوصف | الافتراضي |

|

||||||

|

|------------|------------------------|---------------------------------------------------------------------------------------------------------------------------|--------------|

|

||||||

|

| البيانات | سلسلة | المسار إلى المجلد الذي يحتوي على الصور التي سيتم الإشارة إليها. | |

|

||||||

|

| det_model | سلسلة، اختياري | نموذج الكشف المدرب المسبق لـ YOLO. الافتراضي هو 'yolov8x.pt'. | 'yolov8x.pt' |

|

||||||

|

| sam_model | سلسلة، اختياري | نموذج القطعة أيا شيء من Ultralytics. الافتراضي هو 'sam_b.pt'. | 'sam_b.pt' |

|

||||||

|

| device | سلسلة، اختياري | الجهاز الذي يتم تشغيل النماذج عليه. الافتراضي هو سلسلة فارغة (وحدة المعالجة المركزية أو وحدة معالجة الرسومات إذا توافرت). | |

|

||||||

|

| output_dir | سلسلة، لا شيء، اختياري | الدليل لحفظ النتائج المرئية. الافتراضي هو مجلد 'التسميات' في نفس دليل 'البيانات'. | لا شيء |

|

||||||

|

|

||||||

|

يأخذ تابع 'auto_annotate' المسار إلى الصور الخاصة بك مع وسيطات اختيارية لتحديد نموذج الكشف المدرب مسبقًا ونموذج التجزئة SAM والجهاز الذي سيتم تشغيل النماذج به والدليل الخروج لحفظ النتائج المرئية.

|

||||||

|

|

||||||

|

تعلم تلقائيًا باستخدام نماذج مدربة مسبقًا يمكن أن يقلل بشكل كبير من الوقت والجهد المطلوب لإنشاء سلاسل بيانات تجزئة عالية الجودة. يكون هذا الأمر مفيدًا خصوصًا للباحثين والمطورين الذين يتعاملون مع مجموعات صور كبيرة ، حيث يتيح لهم التركيز على تطوير النماذج وتقييمها بدلاً من التسمية اليدوية البطيئة.

|

||||||

|

|

||||||

|

## الاقتباسات والتقديرات

|

||||||

|

|

||||||

|

إذا وجدت SAM مفيدًا في البحث أو العمل التطويري الخاص بك ، يرجى النظر في استشهاد بحثنا:

|

||||||

|

|

||||||

|

!!! Quote ""

|

||||||

|

|

||||||

|

=== "البيبتيكس"

|

||||||

|

```البيبتيكس

|

||||||

|

@misc{kirillov2023segment,

|

||||||

|

title={Segment Anything},

|

||||||

|

author={Alexander Kirillov and Eric Mintun and Nikhila Ravi and Hanzi Mao and Chloe Rolland and Laura Gustafson and Tete Xiao and Spencer Whitehead and Alexander C. Berg and Wan-Yen Lo and Piotr Dollár and Ross Girshick},

|

||||||

|

year={2023},

|

||||||

|

eprint={2304.02643},

|

||||||

|

archivePrefix={arXiv},

|

||||||

|

primaryClass={cs.CV}

|

||||||

|

}

|

||||||

|

```

|

||||||

|

|

||||||

|

نود أن نعبر عن امتناننا لـ Meta AI لإنشاء وصيانة هذا المورد القيم لمجتمع البصريات الحواسيبية.

|

||||||

|

|

||||||

|

*أكلمات دالة: سلسلة المفعولة, نموذج القطعة شيء ما, SAM, Meta SAM, التجزئة, التشفير المميز, آلة آي, segment, Ultralytics, نماذج مدربة مسبقا, SAM الاساسي, SAM الكبير, تجزئة الكيانات, الرؤية الكمبيوترية, آي الاصطناعية, التعلم الآلي, تسمية بيانات, قناع التجزئة, نموذج الكشف, نموذج الكشف YOLO, البيبتكس, Meta AI.*

|

||||||

121

docs/ar/models/yolo-nas.md

Normal file

121

docs/ar/models/yolo-nas.md

Normal file

@ -0,0 +1,121 @@

|

|||||||

|

---

|

||||||

|

comments: true

|

||||||

|

description: استكشف التوثيق المفصل لـ YOLO-NAS ، وهو نموذج كشف الكائنات المتطور. تعلم المزيد عن ميزاته والطرز المدربة مسبقًا واستخدامه مع واجهة برمجة Ultralytics Python وأكثر من ذلك.

|

||||||

|

keywords: YOLO-NAS, Deci AI, كشف الكائنات, deep learning, البحث في الهندسة العصبية, واجهة برمجة Ultralytics Python, نموذج YOLO, الطرز المدربة مسبقًا, كمّية, التحسين, COCO, Objects365, Roboflow 100

|

||||||

|

---

|

||||||

|

|

||||||

|

# YOLO-NAS

|

||||||

|

|

||||||

|

## نظرة عامة

|

||||||

|

|

||||||

|

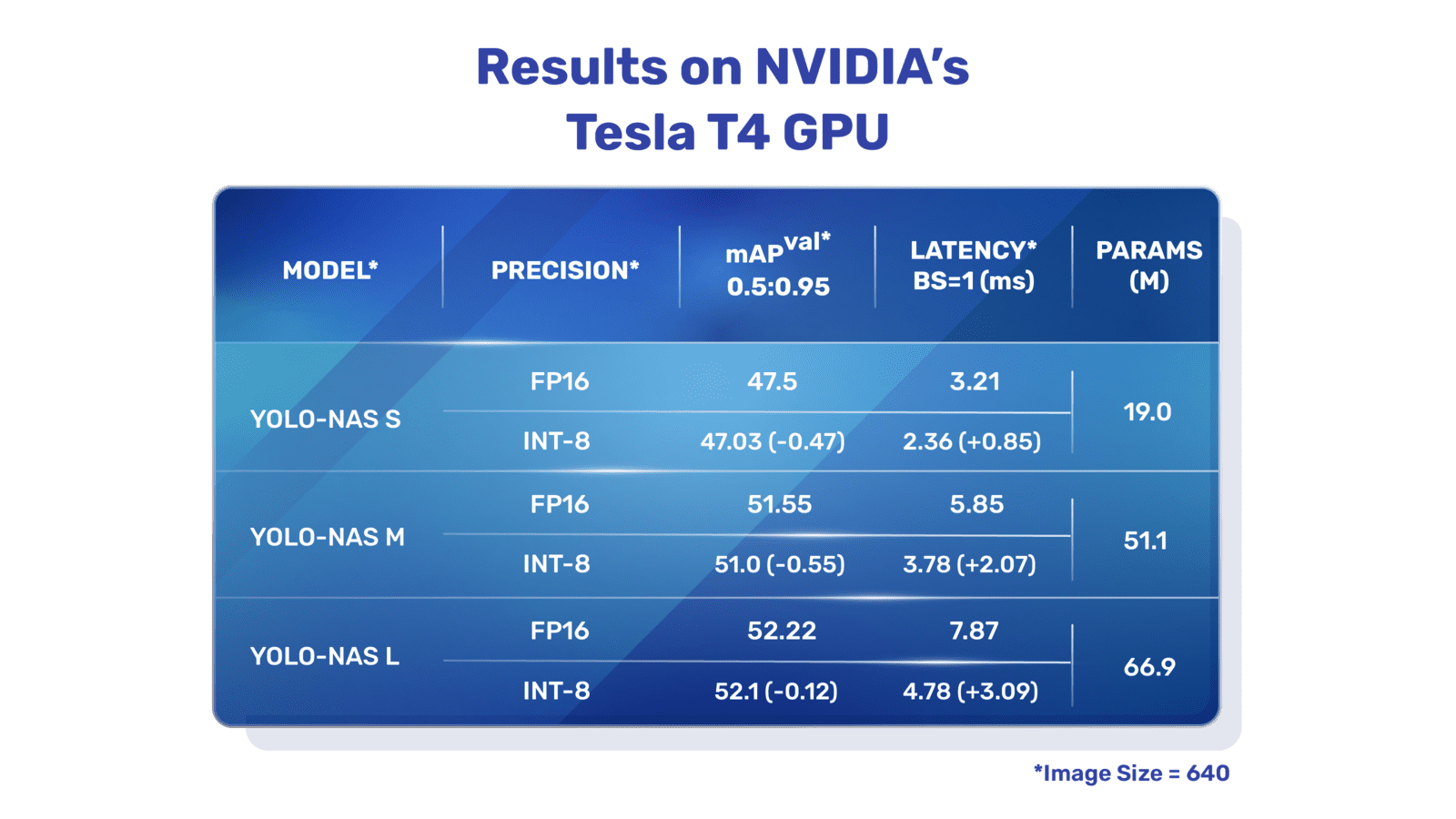

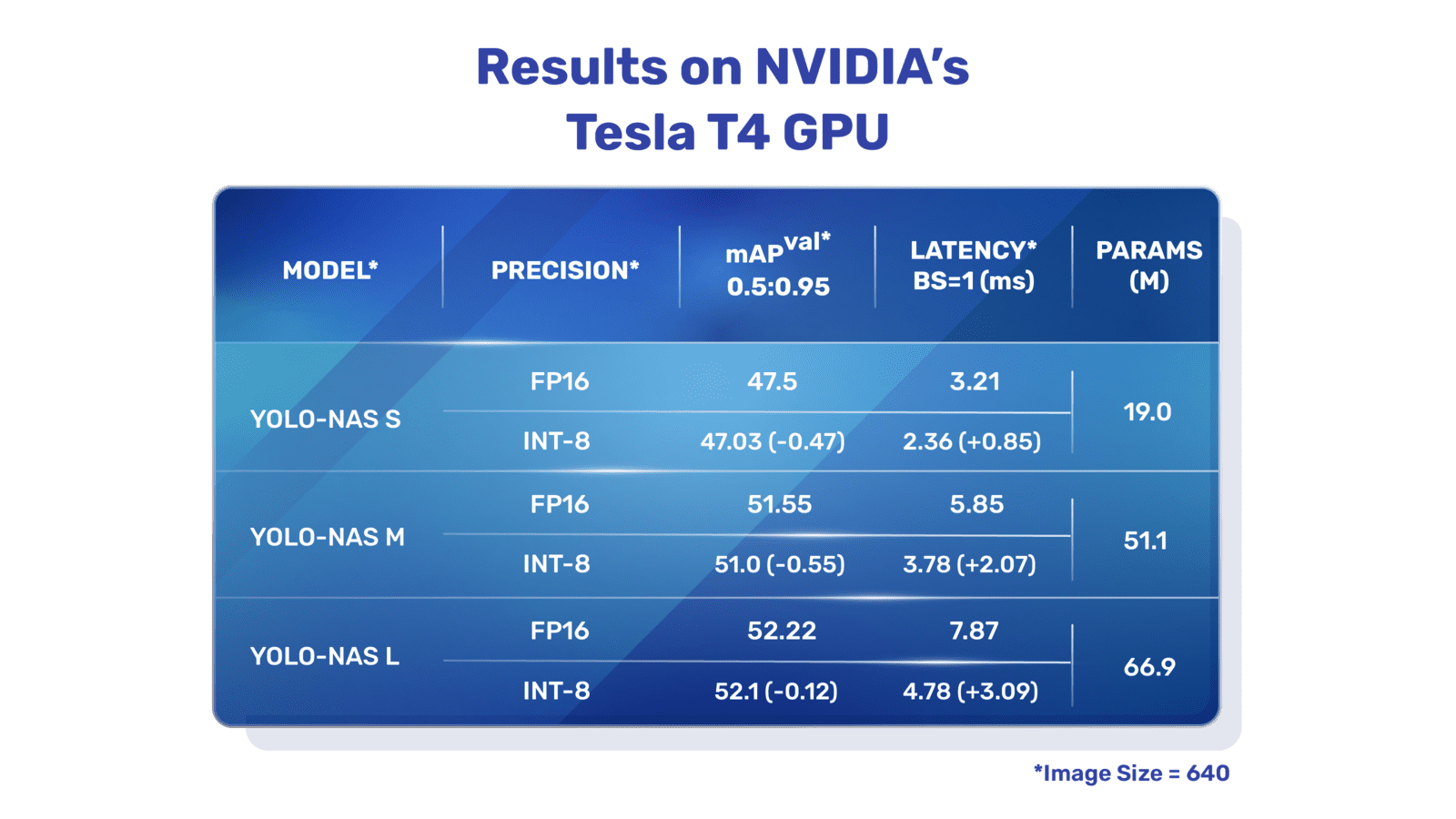

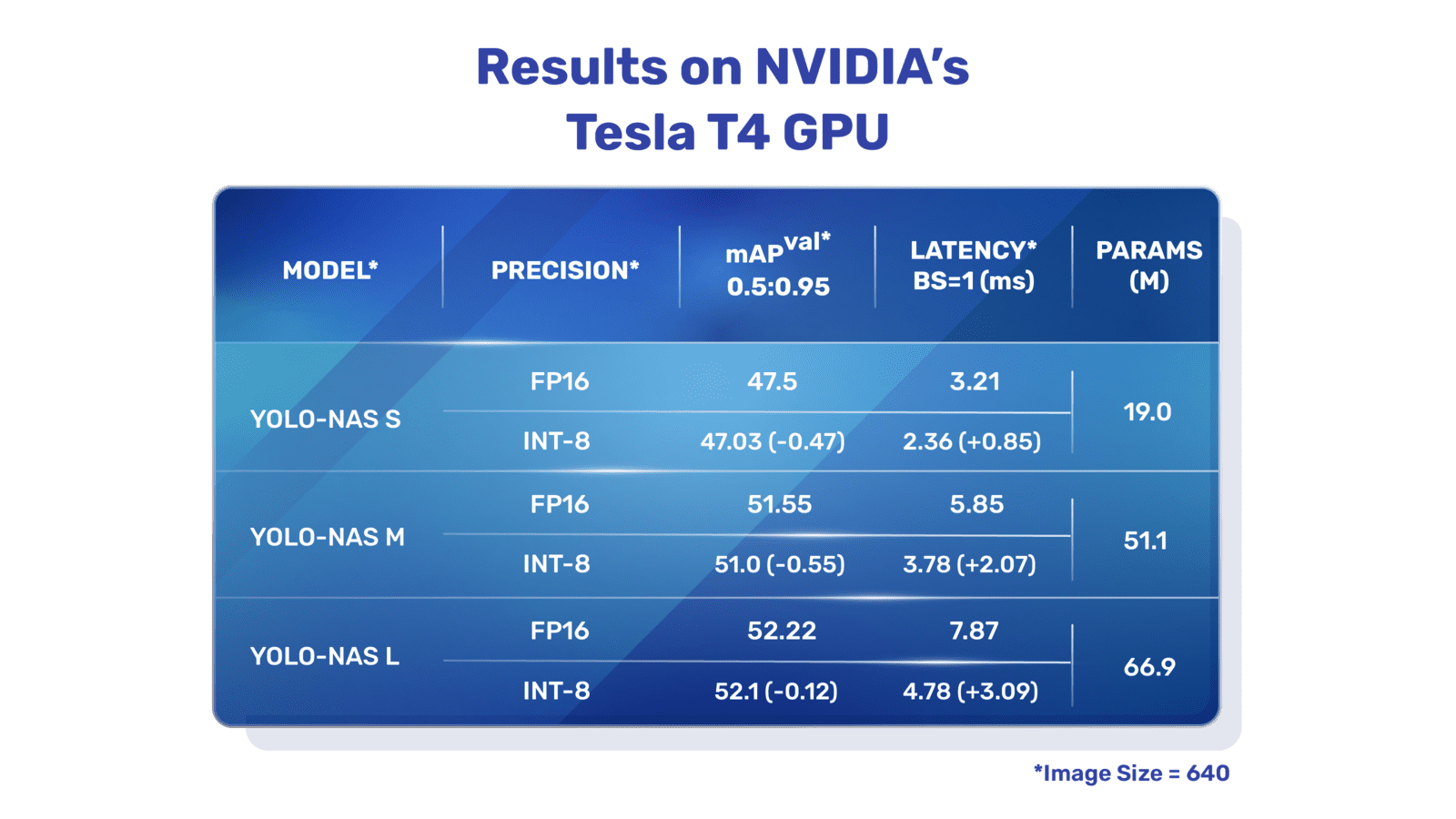

تم تطوير YOLO-NAS بواسطة ديسي ايه اي ، وهو نموذج استشعار الكائنات الطائرة للأمام الذي يقدم تطورًا مبتكرًا. إنه منتج تكنولوجيا بحث الهندسة العصبية المتقدمة ، المصممة بعناية لمعالجة القيود التي كانت تعاني منها النماذج السابقة YOLO. مع تحسينات كبيرة في دعم التمثيل الكموني وتنازلات الدقة والتأخير ، يمثل YOLO-NAS قفزة كبيرة في كشف الكائنات.

|

||||||

|

|

||||||

|

|

||||||

|

**نظرة عامة على YOLO-NAS.** يستخدم YOLO-NAS كتلًا تفاعلية للتمثيل الكموني وتمثيل كمي للحصول على أداء مثلى. يواجه النموذج ، عند تحويله إلى الإصدار المكون من 8 بت ، انخفاضًا طفيفًا في الدقة ، وهو تحسين كبير على النماذج الأخرى. تتوج هذه التطورات بتصميم متفوق ذي قدرات استشعار للكائنات لا مثيل لها وأداء متميز.

|

||||||

|

|

||||||

|

### المزايا الرئيسية

|

||||||

|

|

||||||

|

- **كتلة أساسية ودية للتمثيل الكموني:** يقدم YOLO-NAS كتلة أساسية جديدة ودية للتمثيل الكموني ، مما يعالج أحد القيود الرئيسية للنماذج السابقة YOLO.

|

||||||

|

- **تدريب متطور وتمثيل كمي:** يستخدم YOLO-NAS نظم تدريب متقدمة وتمثيلًا للكم بعد التدريب لتعزيز الأداء.

|

||||||

|

- **تحسين AutoNAC والتدريب المسبق:** يستخدم YOLO-NAS تحسين AutoNAC ويتم تدريبه مسبقًا على مجموعات بيانات بارزة مثل COCO و Objects365 و Roboflow 100. يجعل هذا التدريب المسبق مناسبًا لمهام استشعار الكائنات الفرعية في بيئات الإنتاج.

|

||||||

|

|

||||||

|

## الطرز المدربة مسبقًا

|

||||||

|

|

||||||

|

استمتع بقوة كشف الكائنات من الجيل القادم مع الطرز المدربة مسبقًا لـ YOLO-NAS التي يوفرها Ultralytics. تم تصميم هذه الطرز لتقديم أداء متفوق من حيث السرعة والدقة. اختر من بين مجموعة متنوعة من الخيارات المصممة وفقًا لاحتياجاتك الخاصة:

|

||||||

|

|

||||||

|

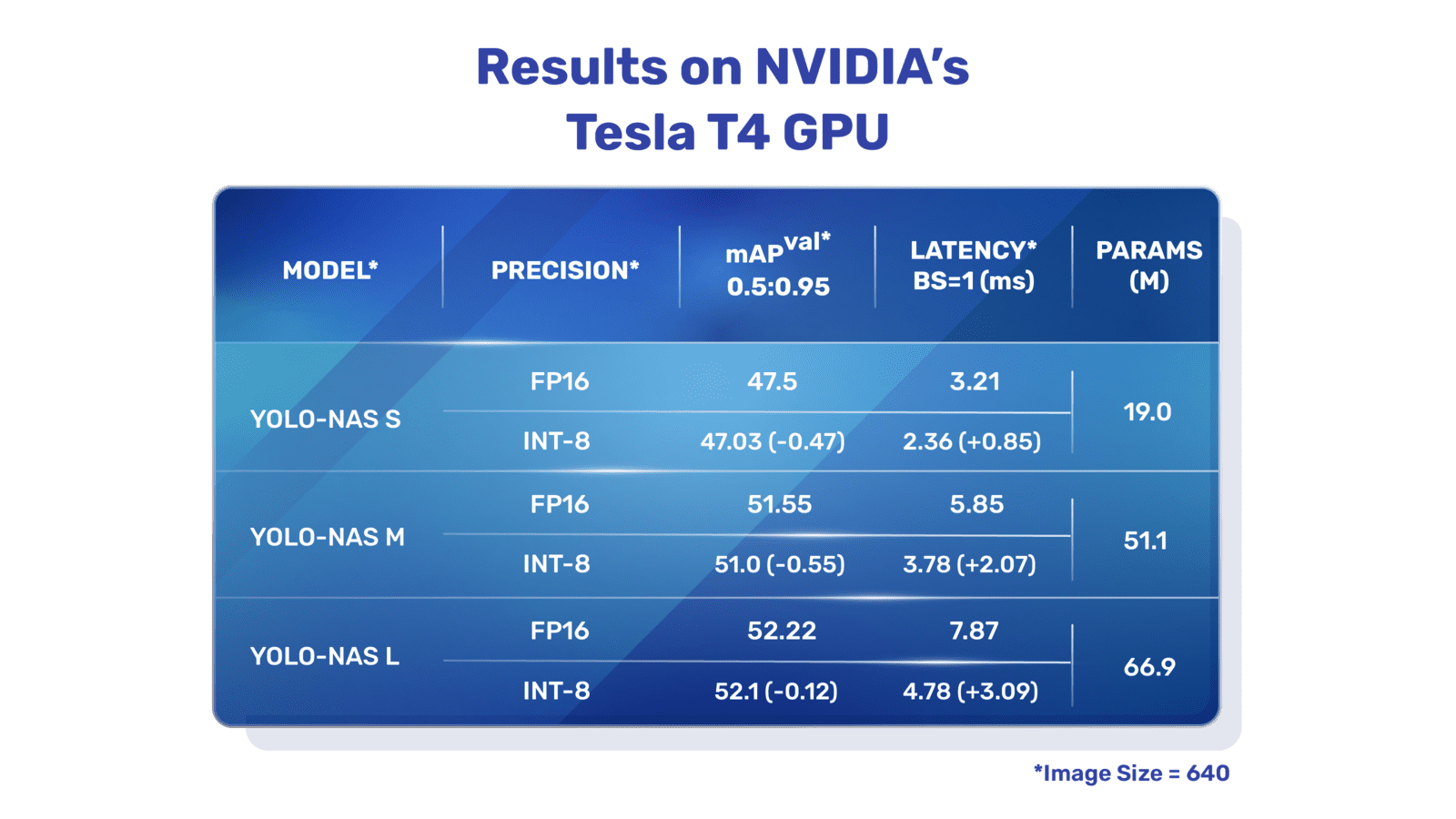

| الطراز | مؤشر التقدير المتوسط (mAP) | تأخر الوقت (ms) |

|

||||||

|

|------------------|----------------------------|-----------------|

|

||||||

|

| YOLO-NAS S | 47.5 | 3.21 |

|

||||||

|

| YOLO-NAS M | 51.55 | 5.85 |

|

||||||

|

| YOLO-NAS L | 52.22 | 7.87 |

|

||||||

|

| YOLO-NAS S INT-8 | 47.03 | 2.36 |

|

||||||

|

| YOLO-NAS M INT-8 | 51.0 | 3.78 |

|

||||||

|

| YOLO-NAS L INT-8 | 52.1 | 4.78 |

|

||||||

|

|

||||||

|

تم تصميم كل نسخة من النموذج لتقديم توازن بين متوسط الدقة (mAP) وتأخير الوقت ، مما يساعدك في تحسين مهام كشف الكائنات الخاصة بك من حيث الأداء والسرعة.

|

||||||

|

|

||||||

|

## أمثلة الاستخدام

|

||||||

|

|

||||||

|

قام Ultralytics بجعل طرز YOLO-NAS سهلة الدمج في تطبيقات Python الخاصة بك عبر حزمة `ultralytics` الخاصة بنا. توفر الحزمة واجهة برمجة التطبيقات بسيطة الاستخدام لتسهيل العملية.

|

||||||

|

|

||||||

|

توضح الأمثلة التالية كيفية استخدام طرز YOLO-NAS مع حزمة `ultralytics` للكشف والتحقق:

|

||||||

|

|

||||||

|

### أمثلة الكشف والتحقق

|

||||||

|

|

||||||

|

في هذا المثال ، نقوم بالتحقق من صحة YOLO-NAS-s على مجموعة بيانات COCO8.

|

||||||

|

|

||||||

|

!!! Example "مثال"

|

||||||

|

|

||||||

|

يوفر هذا المثال رمز بسيط لعملية الكشف والتحقق لـ YOLO-NAS. لمعالجة نتائج الاستدلال ، انظر وضع [توقع](../modes/predict.md). لاستخدام YOLO-NAS مع وضعيات إضافية ، انظر [توصيف](../modes/val.md) و[تصدير](../modes/export.md). لا يدعم نظام YOLO-NAS على حزمة `ultralytics` عملية التدريب.

|

||||||

|

|

||||||

|

=== "Python"

|

||||||

|

|

||||||

|

يمكن تمرير نماذج PyTorch المدربة مسبقًا `*.pt` إلى فئة `NAS()` لإنشاء نموذج في Python:

|

||||||

|

|

||||||

|

```python

|

||||||

|

from ultralytics import NAS

|

||||||

|

|

||||||

|

# تحميل نموذج YOLO-NAS-s المدرب مسبقًا على COCO

|

||||||

|

model = NAS('yolo_nas_s.pt')

|

||||||

|

|

||||||

|

# عرض معلومات النموذج (اختياري)

|

||||||

|

model.info()

|

||||||

|

|

||||||

|

# التحقق من صحة النموذج على مجموعة بيانات مثال COCO8

|

||||||

|

results = model.val(data='coco8.yaml')

|

||||||

|

|

||||||

|

# تشغيل استدلال باستخدام نموذج YOLO-NAS-s على صورة 'bus.jpg'

|

||||||

|

results = model('path/to/bus.jpg'))

|

||||||

|

```

|

||||||

|

|

||||||

|

=== "CLI"

|

||||||

|

|

||||||

|

تتوفر أوامر CLI لتشغيل النماذج مباشرة:

|

||||||

|

|

||||||

|

```bash

|

||||||

|

# تحميل نموذج YOLO-NAS-s المدرب مسبقًا على COCO والتحقق من أدائه على مجموعة بيانات مثال COCO8

|

||||||

|

yolo val model=yolo_nas_s.pt data=coco8.yaml

|

||||||

|

|

||||||

|

# تحميل نموذج YOLO-NAS-s المدرب مسبقًا على COCO والتنبؤ بالاستدلال على صورة 'bus.jpg'

|

||||||

|

yolo predict model=yolo_nas_s.pt source=path/to/bus.jpg

|

||||||

|

```

|

||||||

|

|

||||||

|

## المهام والأوضاع المدعومة

|

||||||

|

|

||||||

|

نحن نقدم ثلاثة أنواع من نماذج YOLO-NAS: الصغير (s) ، المتوسط (m) ، والكبير (l). يتم تصميم كل نسخة لتلبية احتياجات الحوسبة والأداء المختلفة:

|

||||||

|

|

||||||

|

- **YOLO-NAS-s**: محسنة للبيئات التي تكون فيها الموارد الحسابية محدودة والكفاءة هي الأهم.

|

||||||

|

- **YOLO-NAS-m**: يقدم نهجًا متوازنًا ، مناسبًا لكشف الكائنات العامة بدقة أعلى.

|

||||||

|

- **YOLO-NAS-l**: مصممة للسيناريوهات التي تتطلب أعلى درجة من الدقة ، حيث الموارد الحسابية أقل قيدًا.

|

||||||

|

|

||||||

|

أدناه نظرة عامة مفصلة عن كل نموذج ، بما في ذلك روابط أوزانهم المدربين مسبقًا ، والمهام التي يدعمونها ، وتوافقهم مع وضعيات التشغيل المختلفة.

|

||||||

|

|

||||||

|

| نوع النموذج | أوزان مدربة مسبقًا | المهام المدعومة | الاستدلال | التحقق | التدريب | التصدير |

|

||||||

|

|-------------|-----------------------------------------------------------------------------------------------|------------------------------------|-----------|--------|---------|---------|

|

||||||

|

| YOLO-NAS-s | [yolo_nas_s.pt](https://github.com/ultralytics/assets/releases/download/v0.0.0/yolo_nas_s.pt) | [كشف الكائنات](../tasks/detect.md) | ✅ | ✅ | ❌ | ✅ |

|

||||||

|

| YOLO-NAS-m | [yolo_nas_m.pt](https://github.com/ultralytics/assets/releases/download/v0.0.0/yolo_nas_m.pt) | [كشف الكائنات](../tasks/detect.md) | ✅ | ✅ | ❌ | ✅ |

|

||||||

|

| YOLO-NAS-l | [yolo_nas_l.pt](https://github.com/ultralytics/assets/releases/download/v0.0.0/yolo_nas_l.pt) | [كشف الكائنات](../tasks/detect.md) | ✅ | ✅ | ❌ | ✅ |

|

||||||

|

|

||||||

|

## الاقتباسات والشكر

|

||||||

|

|

||||||

|

إذا استخدمت YOLO-NAS في أعمالك البحثية أو التطويرية ، يرجى الاستشهاد بمشروع SuperGradients:

|

||||||

|

|

||||||

|

!!! Quote ""

|

||||||

|

|

||||||

|

=== "BibTeX"

|

||||||

|

|

||||||

|

```bibtex

|

||||||

|

@misc{supergradients,

|

||||||

|

doi = {10.5281/ZENODO.7789328},

|

||||||

|

url = {https://zenodo.org/record/7789328},

|

||||||

|

author = {Aharon, Shay and {Louis-Dupont} and {Ofri Masad} and Yurkova, Kate and {Lotem Fridman} and {Lkdci} and Khvedchenya, Eugene and Rubin, Ran and Bagrov, Natan and Tymchenko, Borys and Keren, Tomer and Zhilko, Alexander and {Eran-Deci}},

|

||||||

|

title = {Super-Gradients},

|

||||||

|

publisher = {GitHub},

|

||||||

|

journal = {GitHub repository},

|

||||||

|

year = {2021},

|

||||||

|

}

|

||||||

|

```

|

||||||

|

|

||||||

|

نعبر عن امتناننا لفريق [SuperGradients](https://github.com/Deci-AI/super-gradients/) في Deci AI لجهودهم في إنشاء وصيانة هذة الموارد القيمة لمجتمع رؤية الحاسوب. نعتقد أن YOLO-NAS ، بتصميمه المبتكر وقدرته الاستشعار المتفوقة للكائنات ، سيصبح أداة حاسمة للمطورين والباحثين على حد سواء.

|

||||||

|

|

||||||

|

*keywords: YOLO-NAS, Deci AI, كشف الكائنات, deep learning, البحث في الهندسة العصبية, واجهة برمجة Ultralytics Python, نموذج YOLO, SuperGradients, الطرز المدربة مسبقًا, كتلة أساسية ودية للتمثيل الكموني, أنظمة تدريب متطورة, تمثيل كمي بعد التدريب, تحسين AutoNAC, COCO, Objects365, Roboflow 100*

|

||||||

98

docs/ar/models/yolov3.md

Normal file

98

docs/ar/models/yolov3.md

Normal file

@ -0,0 +1,98 @@

|

|||||||

|

---

|

||||||

|

comments: true

|

||||||

|

description: احصل على نظرة عامة حول YOLOv3 و YOLOv3-Ultralytics و YOLOv3u. تعرف على ميزاتها الرئيسية واستخدامها والمهام المدعومة للكشف عن الكائنات.

|

||||||

|

keywords: YOLOv3، YOLOv3-Ultralytics، YOLOv3u، الكشف عن الكائنات، إجراء، التدريب، Ultralytics

|

||||||

|

---

|

||||||

|

|

||||||

|

# YOLOv3 و YOLOv3-Ultralytics و YOLOv3u

|

||||||

|

|

||||||

|

## النظرة العامة

|

||||||

|

|

||||||

|

يقدم هذا الوثيقة نظرة عامة على ثلاث نماذج مرتبطة بكشف الكائنات ، وهي [YOLOv3](https://pjreddie.com/darknet/yolo/) و [YOLOv3-Ultralytics](https://github.com/ultralytics/yolov3) و [YOLOv3u](https://github.com/ultralytics/ultralytics).

|

||||||

|

|

||||||

|

1. **YOLOv3:** هذه هي الإصدار الثالث من خوارزمية You Only Look Once (YOLO) للكشف عن الكائنات. قام جوزيف ريدمون بتطويرها بالأصل ، وقد قامت YOLOv3 بتحسين سابقيها من خلال إدخال ميزات مثل التنبؤات متعددة المقياس وثلاثة أحجام مختلفة من نوى الكشف.

|

||||||

|

|

||||||

|

2. **YOLOv3-Ultralytics:** هذه هي تنفيذ Ultralytics لنموذج YOLOv3. يقوم بإعادة إنتاج بنية YOLOv3 الأصلية ويقدم وظائف إضافية ، مثل دعم المزيد من النماذج المدربة مسبقًا وخيارات تخصيص أسهل.

|

||||||

|

|

||||||

|

3. **YOLOv3u:** هذا هو الإصدار المُحدّث لـ YOLOv3-Ultralytics الذي يدمج رأس الكشف بدون مشتركات وبدون مستخدم الكائن الذي يستخدم في نماذج YOLOv8. يحتفظ YOLOv3u بنفس بنية العمود الفقري والعنق مثل YOLOv3 ولكن برأس الكشف المُحدث من YOLOv8.

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

## الميزات الرئيسية

|

||||||

|

|

||||||

|

- **YOLOv3:** قدم استخدام ثلاث مقياسات مختلفة للكشف ، باستخدام ثلاثة أحجام مختلفة من نوى الكشف: 13x13 ، 26x26 و 52x52. هذا يحسن بشكل كبير دقة الكشف للكائنات ذات الأحجام المختلفة. بالإضافة إلى ذلك ، أضاف YOLOv3 ميزات مثل التنبؤات متعددة العلامات لكل مربع محاذاة وشبكة استخراج سمات أفضل.

|

||||||

|

|

||||||

|

- **YOLOv3-Ultralytics:** توفر تنفيذ Ultralytics لـ YOLOv3 نفس الأداء مثل النموذج الأصلي ولكنه يأتي مع دعم إضافي للمزيد من النماذج المدربة مسبقًا وطرق تدريب إضافية وخيارات أسهل للتخصيص. هذا يجعلها أكثر مرونة وسهولة استخداماً للتطبيقات العملية.

|

||||||

|

|

||||||

|

- **YOLOv3u:** يدمج هذا النموذج المُحدّث رأس الكشف بدون مشتركات وبدون مستخدم الكائن من YOLOv8. من خلال إزالة الحاجة إلى صناديق المرجع المحددة مسبقًا ودرجات تكون الكائن ، يمكن أن يحسن تصميم رأس الكشف هذا قدرة النموذج على كشف الكائنات ذات الأحجام والأشكال المتنوعة. هذا يجعل YOLOv3u أكثر مرونة ودقة لمهام كشف الكائنات.

|

||||||

|

|

||||||

|

## المهام المدعومة والأوضاع

|

||||||

|

|

||||||

|

تم تصميم سلسلة YOLOv3 ، بما في ذلك YOLOv3 و YOLOv3-Ultralytics و YOLOv3u ، خصيصًا لمهام الكشف عن الكائنات. يشتهر هذه النماذج بفعاليتها في سيناريوهات العالم الحقيقي المختلفة ، مع توازن دقة الكشف والسرعة. يوفر كل طراز ميزات وتحسينات فريدة ، مما يجعلها مناسبة لمجموعة متنوعة من التطبيقات.

|

||||||

|

|

||||||

|

يدعم النماذج الثلاثة وضعًا شاملاً من الأوضاع ، مما يضمن مرونة في مراحل مختلفة من نموذج النشر والتطوير. هذه الأوضاع تشمل [التمييز](../modes/predict.md) ، [التحقق](../modes/val.md) ، [التدريب](../modes/train.md) و [التصدير](../modes/export.md) ، مما يوفر للمستخدمين مجموعة كاملة من أدوات فعالة للكشف عن الكائنات.

|

||||||

|

|

||||||

|